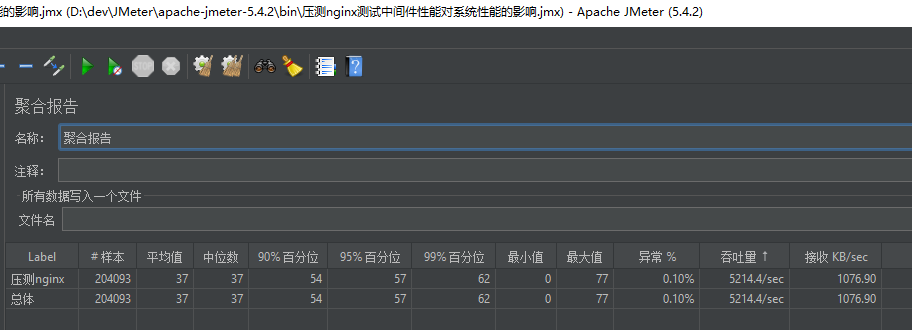

技术总览项目搭建流程环境搭建前端基础商品分类管理分类数据封装树形列表组件前端路由规则树形列表请求数据请求接口数据网关路由转发请求跨域问题逻辑删除后端实现前端实现树形控件展开优化新增分类记录前端后端接口修改分类记录前端后端节点拖拽前端拖拽效果分类数据拖拽关联后端批量删除节点前端后端商品品牌管理列表功能对话框第三方服务对话框再优化SPU和SKU品牌关联分类SPU和SKU属性分组分页查询后端前端新增属性分组属性分组关联属性属性分组未关联属性规格参数新增规格参数查询规格参数修改规格参数销售属性商品维护商品新发布录入商品基本信息录入规格参数录入销售属性SPU管理商品管理仓储服务仓库列表查询商品库存采购需求新建采购需求查询采购需求合并采购需求采购单领取采购单采购完成整合ElasticSearch环境安装ES常用WEB API节点信息相关索引文档CURD相关BULK批量相关检索相关Query DSL的语法Aggregation聚合分析相关Mapping映射字段类型核心类型复合类型地理类型特定类型多字段muti-fields映射MappingAPI分词器Tokenizer分词相关APIik分词器自定义ik扩展词库Elasticsearch-Rest-ClientJava High Level REST Client APIRequestOptionsDocument APIsSearch APIsES在项目中的应用商品上架nested数据类型数据渲染Thymeleaf渲染商城首页渲染商品分类二三级菜单域名访问环境压力测试性能指标JMeter接口性能优化JVM内存模型JconsoleJvisualvm中间件性能影响分析压测首页性能优化策略缓存整合redis缓存商品分类数据缓存相关问题分布式锁基础实现Redisson缓存数据一致性SpringCache配置使用自动配置原理相关注解相关概念SpringCache的不足前台检索业务搭建检索页面检索逻辑检索页面DSL语句用Java动态构建DSL封装检索结果前端数据渲染拼接检索参数面包屑导航商品详情线程池详解业务逻辑异步编排认证服务短信验证码阿里云短信验证码服务用户注册业务用户登录账号/手机+密码登录社交登录单点登录开源项目业务实现分布式session共享Session的使用问题集群session共享子域session共享分布式集群session解决方案自定义SpringSessionSpringSession核心原理购物车服务页面跳转后端获取购物车添加购物车更改购物项消息队列RabbitMQDocker安装RabbitMQWEB界面简介基本用法延时队列SpringBoot整合RabbitMQ整合流程自动配置原理AmqpAdminAPIRabbitTemplateAPI定制消息序列化器@RabbitListener可靠性投递订单服务页面环境订单中心登录拦截订单确认页Feign远程调用携带cookie远程调用异步编排页面数据渲染提交订单接口幂等性方案订单提交幂等性问题创建订单逻辑付款页渲染本地事务分布式系统定理分布式事务Seata分布式事务异步确保型方案消息可靠性投递支付业务支付宝支付生产环境沙箱环境内网穿透电脑网站支付用户同步通知页服务器异步通知收单加密算法秒杀业务后台系统后端设计秒杀商品上架定时任务Cron表达式SpringBoot整合定时任务分布式场景查询秒杀商品高并发系统设计秒杀流程后端总览前端总览技术设计亮点问题解决方案项目前端设计商品分类树形列表设计跨域解决方法逻辑删除树形控件展开优化【重点】新增和修改数据请求参数校验AOP的应用场景MP分页查询Object规范SPU和SKUES节点启动报错docker无法拉取镜像ES文档映射设计响应类R解决服务调用端类型自动转换问题商品库存返回值处理Nginx携带客户端的请求头JMeter压测大量异常的问题Jvisualvm更改插件地址性能优化策略缓存操作对象问题缓存失效相关问题检索商品页面的DSL语句构建商品详情页面用户注册用户注册流程引入短信接口后的业务流程POST请求处理后转发GET请求处理接口报错用户登录方案平台账号密码登录社交账号登录注册单点登录session共享SpringSession原理购物车方案Feign远程调用丢失请求头接口幂等性分布式系统定理消息可靠投递支付宝支付业务流程秒杀商品上架定时任务方案秒杀库存预热简历项目经验分布式基础要点附录

技术总览

技术栈

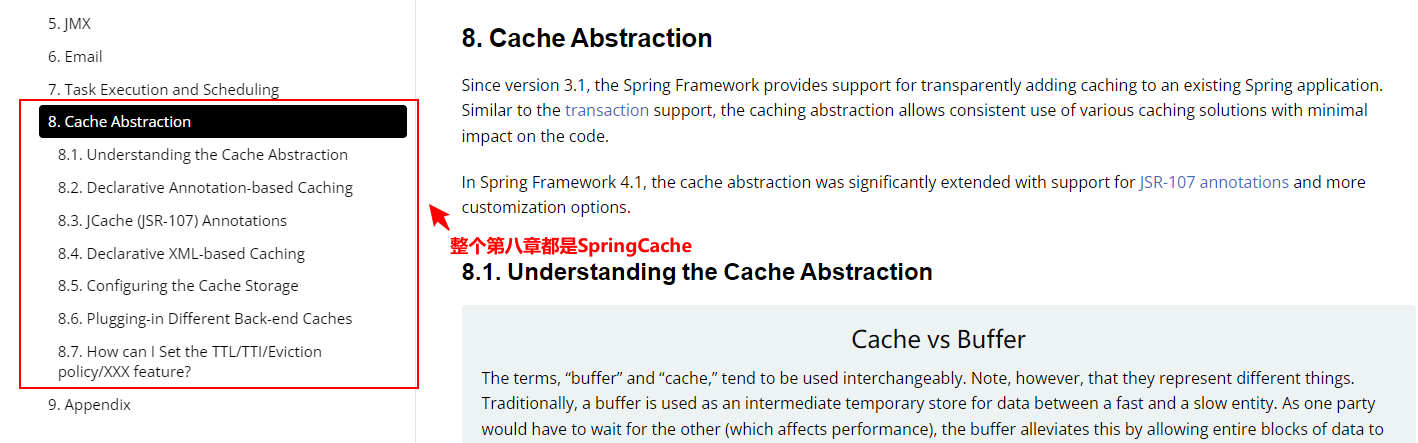

后端:SpringBoot、SpringCloud、Docker、MybatisPlus、MySQL、Redis、Nacos、Nginx、JSR303、Elasticsearch、Redisson、SpringCache、RabbitMQ

前端:VUE、ELEMENT-UI

测试:Jmeter

业务逻辑:商品服务、购物车、订单、结算、库存、秒杀

分布式架构:SpringCloud+Nacos【配置中心、注册中心】、Sentinel流量保护、Seata分布式事务控制、网关SpringCloud GATEWAY、Ribbon负载均衡、远程调用OpenFeign、链路追踪Slueth、缓存、session同步方案、全文商品信息检索ES、异步编排、线程池、压力测试、性能调优、redis分布式锁、MySQL主从分片集群、缓存Redis集群、RabbitMQ镜像集群队列【实现服务异步解耦和分布式数据一致性】、线上监控系统Prometheus+grafana【Prometheus对Sleuth搜集的调用链路信息进行聚合分析,由grafana进行可视化和展示,通过Prometheus提供的AlterManager实时得到服务的告警信息以邮件和手机短信的方式通知给开发和运维人员】、ELK【ES、Kibana、LogStash】日志处理【存储和文书检索、LogStash负责搜集日志并存入ES、使用Kibana从ES中检索相关的信息快速定位线上的问题】、服务熔断降级、高并发场景下的编码方式、阿里云对象存储服务存储图片和视频等

集群架构:一主两从k8s集群、使用KUBESPHERE平台控制整个k8s集群、持续集成持续部署【CI/CD】【即开发人员敲完代码,以流水线的形式自动化的打包、发布、测试、运行、上线;开发人员将代码提交到远程库、运维人员通过自动化部署工具从远程库获取代码打包成Docker镜像,使用K8s集成Docker服务组成集群以Docker容器的方式进行运行】、jenkins自动化部署

商业模式:B2C商家对用户【商业零售】

微服务总览:

前端:admin-vue【后台管理系统,码云人人开源

/renren-security】、shop-vue前台界面分布式架构服务治理:Nacos注册配置中心、Seata分布式事务、Sentinel服务容错降级限流、OpenFeign服务远程调用和负载均衡、Slueth服务调用链路追踪【zipkin可视化追踪】、GATEWAY API网关【限流、鉴权、熔断降级、过滤、路由、负载均衡】,使用Prometheus+grafana对应用进行监控

业务微服务群:商品、支付、优惠、用户、仓储、秒杀、订单、检索、中央认证【单点登录、社交注册】、购物车、后台管理【新增商品】

第三方服务:物流信息检索、短信发送、金融支付、退款、对账、用户身份认证

数据支撑层:缓存redis集群、数据持久化mysql集群【使用shardingSphere对mysql进行分库分表操作】、消息队列RabbitMQ集群、全文检索【ES集群】、图片视频存储【阿里云OSS】

软件版本

【软件环境安装事项】

mysql8.x的文件位置由

/etc/mysql变化为/etc/mysql/conf.d,容器数据卷的挂载需要由-v /mydata/mysql/conf:/etc/mysql \改为-v /mydata/mysql/conf:/etc/mysql/conf.d \

软件 原始版本 备注 VirtualBox 6.0.12 Vagrant 2.2.5 docker 19.03.2 docker -vmysql 5.7.27 redis 4.0 maven 3.6.1 nodejs 10.16.3 LTS SpringBoot 2.1.8.RELEASE MyBatisPlus 3.2.0 Lombok 1.18.8 Httpcore 4.4.12 Commons-lang 2.6 Mysql驱动 8.0.17 servlet-api 2.5 nacos-server 1.1.4 gson 2.8.5 nginx 1.10 Jmeter 5.2.1 Elasticsearch 7.4.2 Kibana 7.4.2 Redisson 3.12.0 SpringCache 2.1.8.RELEASE SpringSession 2.1.8.RELEASE RabbitMQ 4.0.3 Seata 2.1.0.RELEASE alipay-sdk-java 4.9.28.ALL 【IDEA插件】

Lombok【简化开发】

MyBatisX【MP开发的,从一个Mapper方法快速定位到XML文件】

Gitee【提交代码到码云】

【VSCode插件】

Auto Close Tag【自动开闭标签】

Auto Rename Tag【】

Chinese简体中文包【】

ESLint【ES语法检查】

HTML CSS Support【对html和css语法提示】

JavaScript(ES6) code snippets【JS的ES6语法提示】

Live Server【】

open in browser【在浏览器打开页面的】

Vetur【开发vue项目最常用的工具】

项目搭建流程

环境搭建

下载VirtualBox7.0.41

下载Vagrant2.4.1

搭建虚拟机环境CentOS7

🚁:Centos对VirtualBox和Vagrant的版本要求

📓:VirtualBox和Vagrant必须是最新版才能通过vagrant连接VirtualBox快速安装Centos7

安装Docker

Docker安装mysql:5.7.27

mysql:5.7有一个文件老是拉取不下来,最后拉的5.7.27;原来的系统默认安装在C盘,重装了,你猜怎么着,又能装了,最后还是装的5.7

mysql的默认字符编码是拉丁,需要修改配置文件将字符编码改为utf-8

镜像拉取不了是DNS服务器的设置问题,解决方法看linux操作手册的docker常见问题

xxxxxxxxxxdocker run -p 3306:3306 --privileged=true --name mysql \-v /malldata/mysql/log:/var/log/mysql \-v /malldata/mysql/data:/var/lib/mysql \-v /malldata/mysql/conf:/etc/mysql \-e MYSQL_ROOT_PASSWORD=Haworthia0715 \-d mysql:5.7【mysql开放root用户远程连接权限】

在mysql本地客户端输入以下两行代码,无需重启可以直接连

xxxxxxxxxxgrant all privileges on *.* to 'root'@'%' identified by 'Haworthia0715' with grant option;flush privileges;Docker安装redis:6.0.8

老师的太老了,自己拉了一个熟悉的

容器数据卷一定要先创建

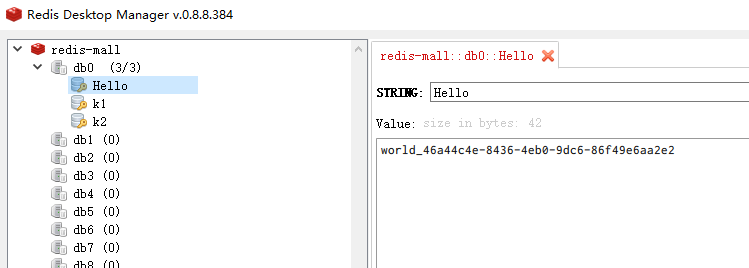

/malldata/redis/conf/redis.conf文件再进行挂载,否则会自动创建redis.conf目录,如果强行修改为文件,redis会直接停掉;先创建了文件就会将容器数据卷识别为对应的文件,一旦没匹配上配置文件,外部任何配置都不会生效使用Redis Desktop Manager连接redis

redis等其他镜像创建容器实例没指定随docker启动而自动启动可以通过命令

docker update redis --restart=always追加设置xxxxxxxxxxdocker run -p 6379:6379 --privileged=true --name redis -v /malldata/redis/data:/data \-v /malldata/redis/conf/redis.conf:/etc/redis/redis.conf \-d redis:6.0.8 redis-server /etc/redis/redis.conf创建商城数据库表

使用数据库脚本创建的,SQLYog的脚本运行一定要点击一次性运行所有查询,否则可能涉及局部脚本操作,而且需要根据数据的位置执行查询,很容易发生各种错误

引入

人人开源/renren-fast后台管理系统后端项目使用的是老师的版本

3.0.0使用该项目的数据库创建后台管理系统数据库

mall_admin表,并修改项目直到项目成功运行因为后端为了尽量和老师的版本保持一致,包括

SpringBoot和Cloud的版本,因为时间久了一旦出现问题很可能找不到合适的解决办法,所以项目后端直接使用的老师的renren-fast交付代码,保持后端版本的一致真特么服了,使用老师交付的代码因为前后台系统的版本不一致存在跨域问题,跨域类的写法发生了变化,老版本SpringBoot的跨域无法适应新的前台请求,这里renren-fast的前后台代码都使用的人人开源仓库最新克隆的,单后台管理系统SpringBoot的版本是2.6.6的

引入

人人开源/renren-fast-vue后台管理系统前端项目这个是直接在Gitee上拉取的,看了版本和老师的一样都是1.2.2

安装nodejs v10.16.3(LTS),直接拿着对应版本到百度搜也会跳出官方下载页面,直接去官网找不一定找得到,直接下载Windows 64-bit Installer: https://nodejs.org/dist/v10.16.3/node-v10.16.3-x64.msi

VScode调出控制台的快捷键是Ctrl+`

renren-fast-vue和老版本变化不大,package.json中少量版本变化,且直接使用老师的交付代码会因为老师整合服务修改了前端的端口和路径问题,导致项目验证码无法正常请求到后端的接口【导致验证码不显示】和跨域设置,这里前端页面直接使用人人开源上克隆的最新版

这里更换多个版本出现无法使用命令

npm install安装的情况,经过评论区指出是node-sass4.9.0安装失败的问题【但是不需要根据评论的下载python,就是node-sass的下载和nodejs的版本适配问题】,而且nodejs的版本和node-sass的版本存在对应关系,对应关系通过网址https://www.npmjs.com/package/node-sass查看;1. 在使用nodejs10.16.3的情况下把项目文件夹下的package.json里面的node-sass4.9.0改成4.9.2;第二将原来的node_modules文件夹删除【也可以使用命令npm rebuild node-sass或者npm uninstall node-sass重装或者卸载node-sass】;第三在项目文件下打开CMD窗口执行npm i node-sass --sass_binary_site=https://npm.taobao.org/mirrors/node-sass/单独安装node-sass[因为使用淘宝镜像会去从github下载,但是下载并不会成功],没报错就是下载成功了;在CMD窗口执行npm install对项目进行安装,没报错就是成功;然后就可以在VScode上使用npm run dev运行项目了使用

人人开源/renren-generator逆向工程生成后端各个服务模块的结构修改端口并测试接口是否能够正常访问这个直接使用的老师的版本,傻逼Maven有些报红,折腾了好久,不影响执行,通过访问控制台;在控制面板选择表生成对应的实体类和前端包括端口,以浏览器下载的方式将main目录和Resources目录下的mapper文件以及vue的前端代码发送给用户,用户在对应模块下自行替换,不像mybatis的插件,这个更加强大,连接口的方法都能生成甚至前端代码都能生成

直接拷贝替换对应main、mapper目录;vue文件不要删,后面会用到,据说这个逆向生成的代码中已经包含了前端例如三级分类的代码和前端的增删改查功能【有点逆天啊】,一般基础的功能前端后端都用逆向工程生成,只有核心的业务逻辑前后端自定义编写

重新搞吧,克隆最新的

人人开源/renren-generator,因为生成的代码中需要使用人人开源/renren-fast中的工具类PageUtils和Query工具类反正人人开源的就直接现场克隆就完事了,在人人开源代码生成器生成的代码中需要依赖renren-fast中的工具类,需要进行拷贝到公共工程下,并在其他模块对公共工程进行引入,同时公共模块下需要引入相关的依赖才能让生成的代码不报错

引入的相关依赖包括mybatisPlus、Lombok、httpcore、commons-lang、mysql驱动[mysql-connector-java]、servlet-api

定义统一返回类R,R继承了

HashMap<String,Object>这个R是从renren-fast项目拷贝过来的

x/*** 返回数据** @author Mark sunlightcs@gmail.com*/public class R extends HashMap<String, Object> {private static final long serialVersionUID = 1L;public R() {put("code", 0);put("msg", "success");}public static R error() {return error(HttpStatus.SC_INTERNAL_SERVER_ERROR, "未知异常,请联系管理员");}public static R error(String msg) {return error(HttpStatus.SC_INTERNAL_SERVER_ERROR, msg);}public static R error(int code, String msg) {R r = new R();r.put("code", code);r.put("msg", msg);return r;}public static R ok(String msg) {R r = new R();r.put("msg", msg);return r;}public static R ok(Map<String, Object> map) {R r = new R();r.putAll(map);return r;}public static R ok() {return new R();}public R put(String key, Object value) {super.put(key, value);return this;}}

前端基础

学习前端知识

笔记在

E:\JavaStudy\project\ol_edu\vpc_ol_js目录下

商品分类管理

分类数据封装

商品分类数据的三级封装逻辑和实现、重点关注这个逻辑中一级分类和二级分类的主键值肯定会发生大于Long类型常量池范围的情况,此时子分类的

parent_cid和父类的catId不能再使用==来过滤流判断是否类的子分类【因为即使值相等也会因为==判断引用地址是否相同始终返回false,导致子分类直接误判,会发生主键太大的一级分类和二级分类的子分类数据全部丢失,表现在前端的效果是子分类数据能成功添加,但是永远显示不出子分类列表】,必须使用Long类型的equals方法来对较大Long类型主键判断分类的parent_cid和父类的catId值相等

商品三级分类

三级分类是很常用的功能

导入pms_category中的所有商品分类数据

查询所有分类并以父子分类方式的结构组装起来方便后台管理系统维护

封装逻辑

查询出所有的商品分类数据,因为mybatis的缓存功能,只有第一次查询需要真正访问数据库,此后访问直接从缓存中获取商品分类数据,使用java8新特性stream流的filter对商品分类进行过滤筛出一级分类,使用map方法对每个一级分类根据当前分类和总的分类列表查询出所有子分类,对一级分类列表的流使用sorted方法按照sort字段进行排序,使用collect聚合函数转成list集合并返回,

对查询某个分类的所有子分类的实现是查询出当前分类的下一级子分类,对查询出的子分类递归调用当前方法查询出二级分类的所有子分类,递归跳出的条件是当前子分类没有子分类,即过滤得到流的元素个数为0,不再执行后续的map方法继续查找所有子分类;查询完成后对每级子分类进行排序并返回每级子分类的List集合

代码实现

卧槽,这里有个数据库mybatis的查询数据缓存【据大佬说是mybatis二级缓存】,能节省超多时间,对数据的封装递归写的这么烂也只需要20ms,但是数据库查询1000条数据要170到180ms,写的烂也不存在啊,数据库查询才是耗时比较久的

xxxxxxxxxx/*** @return {@link List }<{@link CategoryEntity }>* @描述 查找所有商品分类,以树形结构对商品分类数据进行封装,* @性能 junit显示一千条数据耗时560ms,为什么浏览器显示响应时间25ms-33ms* 这个可能是自带缓存啊,下面这段代码服务器重启以后第一次执行是198ms,此后每次执行都是18-20ms,* 但是junit执行同样的代码每次都需要560ms* 实际第一次这段代码执行需要200ms,此后每次执行只需要20ms左右,浏览器响应也只需要25ms左右,junit的测试结果* 和直接在程序中测差别很大啊* 这里第一次请求耗时长是因为后续数据库查询走的mybatis的缓存* @author Earl* @version 1.0.0* @创建日期 2024/02/23* @since 1.0.0*/public List<CategoryEntity> listWithTree(){//long initTime=System.currentTimeMillis();//1. 查询所有商品分类List<CategoryEntity> categoryList = baseMapper.selectList(null);//2. 组装商品分类为父子结构//找到所有一级商品分类并封装成list集合,一级商品分类的标志是字段parent_cid为0,使用Stream流实现List<CategoryEntity> firstLevelCategory = categoryList.stream().filter(category -> category.getParentCid() == 0).map(curCategory->{//获取当前商品的子商品分类需要传递当前商品和所有商品curCategory.setChildren(getChildren(curCategory,categoryList));return curCategory;}).//排序按照升序排序,即sort字段小的排在前面sorted((category1,category2)->(category1.getSort()==null?0:category1.getSort())-(category2.getSort()==null?0:category2.getSort())).collect(Collectors.toList());//System.out.println(System.currentTimeMillis()-initTime+"ms");return firstLevelCategory;}/*** @param rootCategory 当前根商品分类* @param categoryList 所有商品分类* @return {@link List }<{@link CategoryEntity }>* @描述 获取当前商品分类的所有子分类* @author Earl* @version 1.0.0* @创建日期 2024/02/23* @since 1.0.0*/private List<CategoryEntity> getChildren(CategoryEntity rootCategory, List<CategoryEntity> categoryList) {List<CategoryEntity> children = categoryList.stream().//所有的流筛选出当前分类的子一级分类//filter(category -> category.getParentCid() == rootCategory.getCatId()).//子分类可能还有子分类,对当前子分类递归求出其所有子分类,跳出递归的条件是最后一级分类没有子分类自然无法执行map方法//这里判断当前分类的parentCid和父分类的catId不能使用等号比较值的大小,因为数据库表初始的一级分类id都比较小,在-128-127范围内,Long类型数据以及其他的包装类都实现了常量池,主键小的时候==永远可以判断值是否相等,但是后期创建的一级分类和二级分类的主键值肯定会超过这个范围,一旦超过这个范围,即使父id和子的pid都是值相等的Long类型也是两个完全不同的对象,用==除了基本数据类型是直接判断值,引用数据类型都是比较引用的内存地址;此时使用Long等包装类的equals方法就是判断的两个Long类型对应的基本类型值是否相等filter(category -> rootCategory.getCatId().equals(category.getParentCid())).map(category->{category.setChildren(getChildren(category,categoryList));return category;}).//对子分类按照表category的sort字段进行升序排序sorted((category1,category2)->(category1.getSort()==null?0:category1.getSort())-(category2.getSort()==null?0:category2.getSort())).collect(Collectors.toList());return children;}

树形列表组件

使用ELEMENT-UI的树形列表控件对三级商品分类数据进行展示和管理

包括前端路由规则、分类树形列表控件、树形列表控件优化

前端路由规则

启动后台管理系统前台

renren-fast-vue和后台模块renren-fast对商品分类进行联调先启动后台系统的服务器模块在启动前端,因为需要获取验证码并对用户名和密码进行验证

在后台管理系统前台的系统管理--菜单管理--新增--目录能创建出和系统管理一样的侧边栏菜单,选择菜单是创建该菜单的二级目录,也是从新增点进去选择已有目录创建菜单

菜单数据和目录数据都会进入renren-fast的对应数据库表mall_admin的sys_menu表中,生成对应的记录

需要在分类维护菜单的页面中对商品分类信息进行增删改

页面路由的规则是

http://localhost:8001/#/路由路径,路由路径对应菜单管理中每个菜单的菜单URL把/换成-如菜单URL

product/category对应页面的路由路径是product-category,完整路径是http://localhost:8001/#/product-category路径和页面的匹配规则是

sys-role对应文件src\views\modules\sys\role.vue,即菜单页面的根目录是src\views\modules,短横线前面的sys是目录名,短横线后面的role是文件名,文件以.vue作为后缀这种.vue文件就是vue中的一个单文件组件,在

E:\JavaStudy\project\ol_edu\vpc_ol_js\vue_demo\vue-demo\APP.vue中有介绍,整个单文件组件的页面会展示在菜单窗口中对应这种规则,商品的菜单URL对应的文件是

src\views\modules\product\category.vue,用自定义模版快捷键vue生成对应的单文件组件模板VSCode自定义文件模板在

C:\Users\Earl\AppData\Roaming\Code\User\snippets目录下,文件--首选项--配置用户片段也能查看已有的自定义文件模板

树形列表

商品分类列表前端组件

树形展示列表使用Element-ui的Tree属性控件

【树形控件】

el-tree标签的data是要展示的所有数据即json数组,props是属性设置【设置每个目录的子目录属性名和要展示的值的属性名】,@node-click是绑定的单击函数

xxxxxxxxxx<el-tree :data="data" :props="defaultProps" @node-click="handleNodeClick"></el-tree><script>export default {data() {return {data: json数组,defaultProps: {//children指json数组下的哪个属性的值是作为节点的子节点的children: 'children',//label是指json数组以及子节点哪个属性的值是作为要展示的文字的label: 'label'}};},methods: {handleNodeClick(data) {console.log(data);}}};</script>【自定义树形节点内容】

可以使用

render-content和scope-slot两种方式删除增加节点,项目使用scope-slot方式render-content是给el-tree组件中添加一个:render-content="renderContent"属性,这里很奇怪,明明是双向绑定的写法,但是这里的renderContent是定义在methods中的一个函数,该方法直接返回节点管理的dom元素【图层包含按钮和点击事件】scope-slot是直接在组件中添加节点管理组件,slot-scope是vue中的插槽机制,即把上诉方法返回的Dom元素写在树形结构组件中【树形节点的管理组件】

这个

@node-click="handleNodeClick"单机函数没啥用,可以删掉xxxxxxxxxx<el-tree:data="categoryTree":props="defaultProps"@node-click="handleNodeClick"><!--{ node, data }是一种解构写法,node是当前标签的节点,这个node不是从数据库获取的每个商品分类对象,而是树形控件自己封装的节点对象,包含节点的额外信息,比如节点是否被选中,节点所属的层级等等,通过node.label可以获取到tree节点的属性值;data是对应树形节点对应的从数据库获取到的商品封装的数据,是完整的每个节点的原始数据--><span class="custom-tree-node" slot-scope="{ node, data }"><span>{{ node.label }}</span><span><el-button type="text" size="mini" @click="() => append(data)">Append</el-button><el-button type="text" size="mini" @click="() => remove(node, data)">Delete</el-button></span></span></el-tree>树形控件优化

点击箭头展开

此时点击整个节点都会弹出节点的子节点,点击删除或者增加节点也会展开子节点,el-tree中有一个属性

expand-on-click-node,该属性值设置为true就表示点击整个节点,节点的所有子节点都会展开;设置成false表示只有点击节点前的箭头节点的子节点才会展开xxxxxxxxxx<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"></el-tree>一级菜单和二级菜单显示append按钮,三级菜单不能增加子菜单,没有子菜单的菜单才能显示Delete按钮

使用v-if来对按钮的显示逻辑进行实现

node.level树形显示当前节点为几级节点,一级值为1,二级值为2,一二级节点给添加节点按钮node.childNodes.length是子节点数组的元素个数,为0表示没有子节点,没有子节点给删除按钮xxxxxxxxxx<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"><span class="custom-tree-node" slot-scope="{ node, data }"><span>{{ node.label }}</span><span><el-button v-if="node.level<=2" type="text" size="mini" @click="() => append(data)">Append</el-button><el-button v-if="node.childNodes.length==0" type="text" size="mini" @click="() => remove(node, data)">Delete</el-button></span></span></el-tree>给商品分类添加选择框

商品分类后期存在批量选中的需求,el-tree的

show-checkbox属性,意思是节点是否可被选择,默认是false,只要在el-tree添加该属性或者赋值为true节点就能显示选中框,而且自带全选和全不选的功能xxxxxxxxxx<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkbox>...</el-tree>补充<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkbox="true">...</el-tree>和上述写法效果是一样的为每个节点添加唯一表示属性

el-tree标签的

node-key属性可以用来作为树节点的唯一标识,每个节点的该属性值在整颗树中应该是唯一的,每个节点的主键是唯一的,所以可以将商品分类的主键id赋值给node-key属性,只需要写属性名catId,树形组件会自动去找每个节点原始数据的指定catId属性xxxxxxxxxx<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkboxnode-key="catId">...</el-tree>

请求数据

请求后端商品分类接口获取商品分类树形列表数据

包括renren-fast-vue向api接口发送请求的方式、网关对请求的转发以及请求跨域处理

请求接口数据

renren-fast-vue前端向后端发起数据请求的方法,响应数据结构、URL配置文件

向后台商品系统发送获取商品树形列表请求

在vue对象的

created方法中【页面数据和方法已经加载,但是还没有渲染,此时可以访问this实例访问当前的vue对象】调用获取菜单分类的方法getCategoryTree(),在getCategoryTree()方法中定义发送请求获取数据renren-fast前台发送请求的方式

注意此时发送请求的ip和端口还是前台项目的ip和端口,需要改为后台管理系统的ip和端口

【GET请求方式】

xxxxxxxxxx// 获取数据列表getDataList () {this.dataListLoading = true//下面的代码是向服务器发送请求获取数据的脚手架代码this.$http({//括号中是请求的地址,需要带/url: this.$http.adornUrl('/sys/role/list'),//请求方式method: 'get',//请求参数,k:v键值对,没有请求参数就直接把params属性删掉即可params: this.$http.adornParams({'page': this.pageIndex,'limit': this.pageSize,'roleName': this.dataForm.roleName})//发送成功执行then方法,then是ES6的异步编排promise的用法,详细笔记见E:\JavaStudy\project\ol_edu\vpc_ol_js\es6_std\12_promise语法.html}).then(({data}) => {if (data && data.code === 0) {this.dataList = data.page.listthis.totalPage = data.page.totalCount} else {this.dataList = []this.totalPage = 0}this.dataListLoading = false})},【POST请求方式】

xxxxxxxxxxremove(node, data) {var ids = [data.catId]this.$http({url: this.$http.adornUrl("/product/category/delete"),method: "post",data: this.$http.adornData(ids, false),}).then(({ data }) => {console.log("删除成功")//这个是重新发送请求刷新列表数据,因为列表数据和树形列表是双向绑定关系,更新了数据自然会重新渲染树形列表,注意这个不是跳转路由this.getCategoryTree()});},【根据格式抽取出代码片段】

在VSCode的文件--首选项--用户代码片段,在vue组件模板中追加下列发送请求的模板

下面是完整模板,该文件包含3个模板,通过在需要的地方输入prefix指定的字符串生成模板,其中的

http-get 请求和http-post 请求是追加的renren-fast-vue发送请求的模板,分别通过httpget和httppost在指定地方快速生成模板xxxxxxxxxx//{// Place your 全局 snippets here. Each snippet is defined under a snippet name and has a scope, prefix, body and// description. Add comma separated ids of the languages where the snippet is applicable in the scope field. If scope// is left empty or omitted, the snippet gets applied to all languages. The prefix is what is// used to trigger the snippet and the body will be expanded and inserted. Possible variables are:// $1, $2 for tab stops, $0 for the final cursor position, and ${1:label}, ${2:another} for placeholders.// Placeholders with the same ids are connected.// Example:// "Print to console": {// "scope": "javascript,typescript",// "prefix": "log",// "body": [// "console.log('$1');",// "$2"// ],// "description": "Log output to console"// }{"生成 vue 模板": {"prefix": "vue","body": ["<template>","<div></div>","</template>","","<script>","//这里可以导入其他文件(比如: 组件, 工具 js, 第三方插件 js, json文件, 图片文件等等) ","//例如: import 《组件名称》 from '《组件路径》 ';","","export default {","//import 引入的组件需要注入到对象中才能使用","components: {},","props: {},","data() {","//这里存放数据","return {","","};","},","//计算属性 类似于 data 概念","computed: {},","//监控 data 中的数据变化","watch: {},","//方法集合","methods: {","","},","//生命周期 - 创建完成(可以访问当前 this 实例) ","created() {","","},","//生命周期 - 挂载完成(可以访问 DOM 元素) ","mounted() {","","},","beforeCreate() {}, //生命周期 - 创建之前","beforeMount() {}, //生命周期 - 挂载之前","beforeUpdate() {}, //生命周期 - 更新之前","updated() {}, //生命周期 - 更新之后","beforeDestroy() {}, //生命周期 - 销毁之前","destroyed() {}, //生命周期 - 销毁完成","activated() {}, //如果页面有 keep-alive 缓存功能, 这个函数会触发","}","</script>","<style lang='scss' scoped>","//@import url($3); 引入公共 css 类","$4","</style>"],"description": "生成 vue 模板"},"http-get 请求": {"prefix": "httpget","body": ["this.\\$http({","url: this.\\$http.adornUrl(''),","method: 'get',","params: this.\\$http.adornParams({})","}).then(({data}) => {","})"],"description": "httpGET 请求"},"http-post 请求": {"prefix": "httppost","body": ["this.\\$http({","url: this.\\$http.adornUrl(''),","method: 'post',","data: this.\\$http.adornData(data, false)","}).then(({ data }) => { });"],"description": "httpPOST 请求"}}$http

$http是项目定义的工具类,定义在

utils/httpRequest.jsxxxxxxxxxximport Vue from 'vue'import axios from 'axios'import router from '@/router'import qs from 'qs'import merge from 'lodash/merge'import { clearLoginInfo } from '@/utils'const http = axios.create({timeout: 1000 * 30,withCredentials: true,headers: {'Content-Type': 'application/json; charset=utf-8'}})/*** 请求拦截,每次发请求都会拦截请求从cookie中获取到后台服务器存入cookie的token放到请求的头信息中供后端服务器校验并进行权限控制*/http.interceptors.request.use(config => {config.headers['token'] = Vue.cookie.get('token') // 请求头带上tokenreturn config}, error => {return Promise.reject(error)})/*** 响应拦截,发生401错误说明token失效,用户没有登录,router.push跳转登录页面*/http.interceptors.response.use(response => {if (response.data && response.data.code === 401) { // 401, token失效clearLoginInfo()router.push({ name: 'login' })}return response}, error => {return Promise.reject(error)})/*** 请求地址处理,请求地址拼接* @param {*} actionName action方法名称,actionName就是用户指定的接口uri,和index.js中定义的协议、IP和端口号等一起拼接成完整url*/http.adornUrl = (actionName) => {// 非生产环境 && 开启代理, 接口前缀统一使用[/proxyApi/]前缀做代理拦截!非生产环境和生产环境的拼串方式不同return (process.env.NODE_ENV !== 'production' && process.env.OPEN_PROXY ? '/proxyApi/' : window.SITE_CONFIG.baseUrl) + actionName}/*** get请求参数处理,上面的示例中已经用了params参数,会通过该参数调用http.adornParams方法,这里就是get请求拼接请求参数的方法,传递的参数写在params对象中* @param {*} params 参数对象* @param {*} openDefaultParams 是否开启默认参数?默认参数是时间戳,这里的开启默认参数的意思是如果开启默认参数,每次发送请求就会在get请求后拼接时间戳,避免浏览器的ajax的get请求结果被浏览器缓存*/http.adornParams = (params = {}, openDefaultParams = true) => {var defaults = {'t': new Date().getTime()}return openDefaultParams ? merge(defaults, params) : params}/*** post请求数据处理* @param {*} data 数据对象* @param {*} openDefaultData 是否开启默认数据?开启还是拼接时间戳* @param {*} contentType 数据格式,不指定默认发送的是json格式的请求参数,参数类型有两种方式,一种是json,参数类型是'application/json; charset=utf-8',还有一种参数类型是form表单,完整类型是'application/x-www-form-urlencoded; charset=utf-8'* json: 'application/json; charset=utf-8'* form: 'application/x-www-form-urlencoded; charset=utf-8'*/http.adornData = (data = {}, openDefaultData = true, contentType = 'json') => {var defaults = {'t': new Date().getTime()}data = openDefaultData ? merge(defaults, data) : datareturn contentType === 'json' ? JSON.stringify(data) : qs.stringify(data)}export default http响应数据展示

【前端代码】

xxxxxxxxxxgetCategoryTree() {this.$http({url: this.$http.adornUrl("/product/category/list/tree"),method: "get",}).then((data) => {console.log("获取数据:...",data);});},【数据响应结构】

data.data是响应内容,我对响应做了封装,返回一个R对象,R继承了HashMap<String,Object>

【解构data方式写法】

{data}的意思是用结构表达式{data}=data,即then参数列表中的data参数去获取响应数据中data对象的data属性,此时then参数列表的data实际上是data.data不使用解构表达式获取数据的写法

xxxxxxxxxxgetCategoryTree() {this.$http({url: this.$http.adornUrl("/product/category/list/tree"),method: "get",}).then((data) => {console.log("获取数据:...",data.data)this.categoryTree=data.data.categoryTree});},使用解构表达式获取数据的写法

xxxxxxxxxxgetCategoryTree() {this.$http({url: this.$http.adornUrl("/product/category/list/tree"),method: "get",}).then(({data}) => {console.log("获取数据:...",data)this.categoryTree=data.categoryTree});},

在

static\config\index.js中定义了请求的ip和端口号如果每个服务都单独指定ip和端口号会显得很复杂也不好实现,直接配置给网关发送请求,由网关进行路由转发,网关端口是88,正确的请求ip和端口是

http://localhost:88xxxxxxxxxx/*** 开发环境*/;(function () {window.SITE_CONFIG = {};// api接口请求地址window.SITE_CONFIG['baseUrl'] = 'http://localhost:8080/renren-fast';// cdn地址 = 域名 + 版本号window.SITE_CONFIG['domain'] = './'; // 域名window.SITE_CONFIG['version'] = ''; // 版本号(年月日时分)window.SITE_CONFIG['cdnUrl'] = window.SITE_CONFIG.domain + window.SITE_CONFIG.version;})();

网关路由转发

网关对请求转发

网关对验证码的请求进行转发

转发需要将被转发的服务注册到注册中心

【renren-fast后台服务注册】

引入common模块和com.google.code.gson.gson2.8.5,common里面服务注册的依赖,引入注册中心的过程看笔记Java生态,这里只做一次演示

renren-fast后台服务的Springboot版本过高,多方权衡,决定把renren-fast的版本降成和Springboot一致2.1.8.RELEASE

【application.yml配置注册中心和服务名】

xxxxxxxxxxspringapplicationnamerenren-fastcloudnacosdiscoveryserver-addr:127.0.0.1:8848【启动类添加注解@EnableDiscoveryClient】

xxxxxxxxxxpublic class RenrenApplication {public static void main(String[] args) {SpringApplication.run(RenrenApplication.class, args);}}【配置网关路由转发】

后台登录验证码的访问格式是

http://localhost:8080/renren-fast/captcha.jpg?uuid=e9ffdca7-538c-41eb-898a-b6c35a45f261但是目前前端的路径统一更改为访问网关

http://localhost:88/api/captcha.jpg?uuid=e9ffdca7-538c-41eb-898a-b6c35a45f261,需要在网关用过滤器对请求路径进行重写路由精确匹配的需要放在模糊匹配的前面才能被匹配上,这点和nginx不一样,nginx是优先精确匹配,如果精确匹配在模糊匹配后面,相应的请求会报401错误

xxxxxxxxxxspringcloudgatewayroutes#配置网关对第三方网站的路由功能,如果请求的参数中含有url=baidu就路由到百度idbaidu_routeurihttps//www.baidu.compredicatesQuery=url,baiduidqq_routeurihttps//www.qq.compredicatesQuery=url,qqidproduct_route#lb意思是负载均衡,后面只需要写服务名urilb//mall-productpredicates#Path断言意思是uri为指定路径就路由到该路由上来,这个表示请求路径的uri以/api开始都路由到renren-fast中#路由精确匹配的需要放在模糊匹配的前面才能被匹配上,这点和nginx不一样,nginx是优先精确匹配,如果精确匹配在模糊匹配后面,相应的请求会报401错误Path=/api/product/**filtersRewritePath=/api/(?<segment>.*),/renren-fast/$\segmentidadmin_routeurilb//renren-fastpredicatesPath=/api/**filters#filters过滤器对请求uri进行重写,RewritePath=/api/(?<segment>.*),/renren-fast/$\{egment}表示将api换成renren-fastRewritePath=/api/(?<segment>.*),/renren-fast/$\segment

请求跨域问题

跨域问题

浏览器从一个网段localhost:8001访问另一个网段localhost:88,浏览器会对请求做出跨域限制,跨域值浏览器不能执行其他网站的脚本,是浏览器同源策略造成的,是浏览器对JavaScript施加的安全限制,同源策略指协议、域名、端口号都要相同,其中一个不同就会产生跨域问题【就是当前服务器地址是localhost:8001;但是想要发送ajax请求给localhost:88是不允许的,http发给https也是不允许的】

同时请求会被403禁止,且会显示请求方式是OPTIONS,表示该请求是一个预检请求,真正的请求还没有发送出去,非简单请求【PUT、DELETE】需要先发送预检请求,详细说明见文档

https://developer.mozilla.org/zh-CN/docs/Web/HTTP/CORS,GET、HEAD、POST请求同时满足Content-Type的值为text/plain、multipart/from-data或者application/x-www-form-urlencoded都是简单请求,只要不是简单请求发送正式请求前就需要发送预检请求,预检请求会先访问服务器是否允许跨域请求,服务器响应允许跨域请求就会发起真实请求,这里的验证码的Content-Type是图片为啥就不会被限制跨域【难道这个接受图片也是文本类型?】,登录请求发送的是post请求,是非简单请求,所以被同源策略限制

【跨域流程】

跨域问题的几种解决方案

根本原因是当前页面网站和想要请求的网站不在同一个域【协议、域名、端口号】

方案1:将前端项目和网关部署到同一台nginx服务器上,这样前端项目和网关就在同一个域,网关再将请求路由到其他的上游服务器上,从头到尾都是访问nginx,这种方式在开发期间很麻烦,因为前端项目和网关在开发中,不可能提前打包部署到nginx上

方案2:服务器给预检请求的响应中添加响应头信息,告诉浏览器服务器允许跨域,可配置的响应头信息如下所示

在网关中统一写一个filter,在请求处理完成后返回前用过滤器给响应头添加上以下字段

Access-Control-Allow-Origin:服务器配置支持哪些来源的跨域请求,如果配置成*表示支持任何来源的跨域请求Access-Control-Allow-Methods:配置支持哪些请求方式跨域访问Access-Control-Allow-Credentials:跨域请求默认不能包含cookie,设置为true可以包含cookieAccess-Control-Expose-Headers:指定XMLHttpRequest对象想从跨域请求中拿到的额外字段,跨域请求XMLHttpRequest.getResponseHeader()【这是浏览器的对象还是服务器的对象】默认只允许拿到六个基本字段:Cache-Control、Content-Language、Content-Type、Expire、Last-Modified、PragmaAccess-Control-Max-Age:指定预检请求响应后多长时间内无需为同一请求发起预检请求,浏览器自身也维护着一个最大有效时间,如果该字段指定的时间大于浏览器默认的最大有效时间,配置将不会生效

网关对跨域问题的实现

添加一个过滤器,对每个请求的响应都添加跨域相关的响应头信息

在网关的目录下创建config包,并通过以下代码配置跨域,SpringBoot已经为用户提供了一个

CorsWebFilter新版renren-fast配置了跨域,这也是之前降级SpringBoot报错的原因,哪个跨域可以直接删了,直接在网关设置跨域,使用这个配置一定要将renren-fast的跨域配置删了,否则会在响应头追加一次跨域配置,即

Access-Control-Allow-Credentials:true,true,其他响应头参数也会被重复设置,会导致浏览器报错响应头不符合配置规范从而仍然跨域失败xxxxxxxxxx/*** @author Earl* @version 1.0.0* @描述 商城的统一跨域配置,Cors是跨域的意思* @创建日期 2024/02/23* @since 1.0.0*/public class MallCorsConfiguration {public CorsWebFilter corsWebFilter(){//2. 创建跨域配置信息对象,注意是cors.reactive.CorsConfigurationSource,//但是创建的时候发现CorsConfigurationSource是一个接口,需要对抽象方法进行实现//双击CorsConfigurationSource快捷键ctrl+h就能显示该接口的实现类,发现有一个基于URL路径的跨域配置信息实现UrlBasedCorsConfigurationSource//仍然是选择cors.reactive.UrlBasedCorsConfigurationSource包下的,因为网关使用的是webflux实现的响应式编程//相关的类都使用cors.reactive.包下的//CorsConfigurationSource source = new CorsConfigurationSource();UrlBasedCorsConfigurationSource source = new UrlBasedCorsConfigurationSource();//4. 创建CorsConfiguration,跨域相关的配置都写在该对象中CorsConfiguration corsConfiguration = new CorsConfiguration();//5. 配置跨域,就是配置预检请求允许跨域的响应头参数了//允许哪些请求头进行跨域,*表示允许所有请求头跨域corsConfiguration.addAllowedHeader("*");//允许哪些请求方式进行跨域,*表示允许所有请求方式跨域corsConfiguration.addAllowedMethod("*");//允许哪个请求来源进行跨域,*表示允许所有请求来源跨域corsConfiguration.addAllowedOrigin("*");//是否允许携带cookie进行跨域,true表示允许携带cookie跨域,不配置跨域请求就会丢失相关的cookie信息corsConfiguration.setAllowCredentials(true);//3. 对跨域配置信息对象的实现类进行配置//source.registerCorsConfiguration(path,config);//path表示对哪些uri进行跨域配置,"/**"表示任意路径//config的类型是CorsConfiguration,需要创建一个CorsConfigurationsource.registerCorsConfiguration("/**",corsConfiguration);//1. 创建CorsWebFilter对象,需要CorsConfigurationSource跨域配置信息对象return new CorsWebFilter(source);}}【预检请求的跨域配置响应效果】

对商品模块进行注册中心注册,对商品列表树形查询的api在网关配置路由断言规则和url重写,并指定商品服务的配置中心配置

目的是为了网关对商品服务的路由

【配置中心注册】

xxxxxxxxxxspring.application.name=mall-productspring.cloud.nacos.config.server-addr=127.0.0.1:8848spring.cloud.nacos.config.namespace=6c0c487b-206b-41fb-8cd2-e4b2c19e0477

逻辑删除

分类数据逻辑删除

后端实现

商品分类的逻辑删除功能后端

mybatisplus逻辑删除实现

mybatisplus的逻辑删除是更新操作,根据id和对应的逻辑删除字段将逻辑存在的指定id的记录的逻辑删除字段改成逻辑删除

配置了逻辑删除查询操作也会自动变成查询满足条件且逻辑删除字段为逻辑未删除的记录

在对应模块的application.yml文件中配置逻辑删除字段值

和默认配置相同可省略

xxxxxxxxxx#mybatisplus逻辑删除配置,这是统一的全局配置,该配置就默认配置,如果配置和默认配置相同可以不写#从mybatisPlus3.3.0以后要配置logic-delete-field属性了,这里是3.2.0不需要配置#logic-delete-field: flag # 全局逻辑删除的实体字段名(since 3.3.0,配置后可以忽略不配置步骤2)logic-delete-value1 # 逻辑已删除值(默认为 1)logic-not-delete-value0 # 逻辑未删除值(默认为 0)配置逻辑删除组件ISqlInjector并注入IOC容器

从MybatisPlus3.1.1开始不再需要配置该ISqlInjector组件,即高版本可省略

xxxxxxxxxxpublic class MyBatisPlusConfiguration{public ISqlInjector sqlInjector(){return new LogicSqlInjector();}}在实体类的逻辑删除标识字段上添加

@Tablelogic注解@Tablelogic注解内部有两个属性value和delval,分别表示代表逻辑未删除的字面值和逻辑删除的字面值,该属性值的默认值都为空字符串,为空字符串会自动获取全局配置,全局配置没有使用默认配置,如果不为空字符串就会优先使用该注解的配置来确定哪些值表示逻辑删除和逻辑未删除【

@Tablelogic注解】xxxxxxxxxx(RetentionPolicy.RUNTIME)(ElementType.FIELD)public @interface TableLogic {/*** 默认逻辑未删除值(该值可无、会自动获取全局配置)*/String value() default "";/*** 默认逻辑删除值(该值可无、会自动获取全局配置)*/String delval() default "";}【配置实例】

xxxxxxxxxx(value = "1",delval = "0")private Integer showStatus;【执行的SQL语句】

xxxxxxxxxx==> Preparing: UPDATE pms_category SET show_status=0 WHERE cat_id IN ( ? ) AND show_status=1==> Parameters: 1432(Long)<== Updates: 1

SpringBoot调整日志级别配置打印MyBatisPlus的SQL语句

在应用的application.yml中配置MyBatisPlus日志级别

这样就能打印dao包下的MyBatisPlus的SQL执行语句

xxxxxxxxxx#将SpringBoot应用的com.earl.mall包下所有类的日志级别调整成DEBUG级别logginglevelcom.earl.malldebug

前端实现

商品分类逻辑删除前端

业务逻辑

删除前弹出提示框是否删除目标节点

弹框使用Element-ui的MessageBox 弹框组件

this.$confirm("弹框提示内容","弹框标题",用于弹框设置的对象)

弹框设置对象中前两个是取消和确认按钮的文本,type是弹框类型,点了确定按钮调用then方法,点了取消按钮调用catch方法,then方法和catch方法无论是否有代码都必须写,否则控制台会报错

this.$message(弹窗消息设置对象)

这是消息弹窗组件,可以单独使用,也可以在其他方法中使用,效果就是弹出提示框

type设置弹窗的颜色,success表示绿色,info表示灰色,message是提示文字

xxxxxxxxxx<template><el-button type="text" @click="open">点击打开 Message Box</el-button></template><script>export default {methods: {open() {this.$confirm('此操作将永久删除该文件, 是否继续?', '提示', {confirmButtonText: '确定',cancelButtonText: '取消',type: 'warning'}).then(() => {this.$message({type: 'success',message: '删除成功!'});}).catch(() => {this.$message({type: 'info',message: '已取消删除'});});}}}</script>

前端发送Post请求携带json格式的商品分类id【id通过树形组件的移除按钮的自动传参原始节点数据的catId获取】,

删除请求响应成功后弹窗删除成功消息提示

再次请求刷新树形列表数据,通过双向绑定更新树形列表

同时删除以后列表的展开状态应该维持原样

el-tree组件有一个属性值

default-expanded-keys,属性值双向绑定一个数组,作用是数组中的元素作为唯一节点标识,该节点会被默认展开,一个节点的父节点的catId可以通过树形组件的node.parent.data.catId获取

代码实现

xxxxxxxxxxremove(node, data) {console.log(data.catId)this.$confirm("将删除该商品分类, 是否继续?", "提示", {confirmButtonText: "确定",cancelButtonText: "取消",type: "warning",}).then(() => {var ids = [data.catId];this.$http({url: this.$http.adornUrl("/product/category/delete"),method: "post",data: this.$http.adornData(ids, false),}).then(({ data }) => {this.$message({type: "success",message: "删除成功!",});this.getCategoryTree();//设置删除节点的父节点为展开状态,expandKey双向绑定了el-tree组件的default-expanded-keys属性//但是现在这个优化不够完美,应该把此前展开的节点设置为默认展开,这样可能需要对节点进行遍历//最好的实现方法是点击展开按钮,默认展开就将当前节点的catId追加到数组中,点击关闭按钮,//就将对应的节点id从数组中移除,这个以后实现//暂时使用追加的方式将删除的节点的父节点追加到默认展开节点列表中,等实现了上一个逻辑这一步就不需要了this.expandKey=[this.expandKey,node.parent.data.catId]});}).catch(() => {this.$message({type: "info",message: "已取消删除",});});},

树形控件展开优化

el-tree组件有节点展开关闭的事件,分别是

node-expand和node-collapse,可以使用这两个事件来在默认展开节点中记录下来被展开的节点唯一标识即节点商品分类的id这是独立翻阅文档做出的前端用户体验优化,面试可以吹

背景

对树形列表中的节点进行逻辑删除,最初的策略是删除单个节点以后直接再次请求被双向绑定的树形列表数据

这种方式出现一个问题,子节点很可能是三级子节点,页面刷新以后展开的节点全部折叠,用户观察不到删除商品分类的效果

针对上述问题进一步优化,使用

el-tree组件的属性default-expanded-keys双向绑定一个数组expandKey,该属性的作用是能够配置在vue对象的生命周期中,数组中存在的节点对应的唯一标识【这里是此前设置的商品分类catId】的对应树形组件的节点将会始终被展开,在每次删除一个节点后将其父节点的唯一主键标识添加到expandKey数组中就能实现删除节点的父节点在节点删除前后都处于展开状态这一方式解决了删除节点刷新数据父节点自动关闭的问题,但是仍然存在其他展开节点,展开节点的子节点在某个节点增删以后自动关闭的问题

需求

对树形控件进行进一步优化,默认请款下所有展开的节点总是处于展开状态,不会因为增删节点重新请求刷新分类数据,任何已经展开的节点都不会被关闭

实现原理

通过翻阅文档,发现树形组件有一个展开事件和关闭事件,通过在展开事件中将被展开节点的唯一主键标识追加到数组

expandKey中设置始终默认展开,在关闭事件发生时从数组expandKey中移除掉对应的节点主键标识和该节点所有已经展开的子节点主键标识【不移除子节点的主键标识即便移除节点的主键标识节点也无法关闭】,关闭事件的函数自动传参第一个参数data是当前节点的原始商品分类对象,第二个参数node是当前节点的Node对象,Node对象中的childNodes是子节点数组,每个子节点对象中有一个expanded属性,为true表示该节点被展开,子节点的data属性中的catId为当前子节点的主键唯一标识,对所有子节点进行遍历,如果子节点是展开状态就从数组expandKey中移除对应的主键标识,最后再从数组中移除当前节点的主键标识,从而实现了只要页面不刷新不重新初始化,树形组件列表的展开关闭状态始终只由节点的展开关闭事件控制,其他任何操作都不会影响节点的展开状态与否,所以原来删除节点后将父节点加入数组expandKey的操作也不在需要了,实现了展开节点始终展开,关闭节点始终关闭;用户可以实时看到节点增删的效果同时也能随心所欲地控制节点展开状态,且后续处理新增节点无需再考虑节点展开与否的问题

代码完整实现

xxxxxxxxxx<template><div><el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkboxnode-key="catId":default-expanded-keys="expandKey"@node-expand="handleNodeExpand"@node-collapse="handleNodeCollapse"><span class="custom-tree-node" slot-scope="{ node, data }"><span></span><span><el-buttonv-if="node.level <= 2"type="text"size="mini"@click="() => append(data)">Append</el-button><el-buttonv-if="node.childNodes.length == 0"type="text"size="mini"@click="() => remove(node, data)">Delete</el-button></span></span></el-tree></div></template><script>export default {components: {},props: {},data() {return {categoryTree: [],expandKey: [],defaultProps: {children: "children",label: "name",},};},computed: {},watch: {},methods: {getCategoryTree() {this.$http({url: this.$http.adornUrl("/product/category/list/tree"),method: "get",}).then(({ data }) => {this.categoryTree = data.categoryTree;});},append(data) {},remove(node, data) {console.log(data.catId);this.$confirm("将删除该商品分类, 是否继续?", "提示", {confirmButtonText: "确定",cancelButtonText: "取消",type: "warning",}).then(() => {var ids = [data.catId];this.$http({url: this.$http.adornUrl("/product/category/delete"),method: "post",data: this.$http.adornData(ids, false),}).then(({ data }) => {this.$message({type: "success",message: "删除成功!",});this.getCategoryTree();//设置删除节点的父节点为展开状态,expandKey双向绑定了el-tree组件的default-expanded-keys属性//但是现在这个优化不够完美,应该把此前展开的节点设置为默认展开,这样可能需要对节点进行遍历//最好的实现方法是点击展开按钮,默认展开就将当前节点的catId追加到数组中,点击关闭按钮,//就将对应的节点id从数组中移除,这个以后实现//暂时使用追加的方式将删除的节点的父节点追加到默认展开节点列表中,等实现了上一个逻辑这一步就不需要了//this.expandKey=[...this.expandKey,node.parent.data.catId]});}).catch(() => {this.$message({type: "info",message: "已取消删除",});});},//当节点被展开记录节点被默认展开handleNodeExpand(data) {console.log(data.catId);this.expandKey = [this.expandKey, data.catId];},//当节点被关闭时从数组中移除掉对应的节点和子节点idhandleNodeCollapse(data, node) {//获取子节点对象数组,不从默认展开节点数组this.expandKey中移除调用子节点父节点即便移除也无法关闭展开状态//所以需要先从this.expandKey移除所有的展开子节点idvar childNodes = node.childNodes;//对子节点对象数组进行遍历,判断节点对象的expanded属性是否为true,为true表示该子节点展开for (var i in childNodes) {if (childNodes[i].expanded == true) {//展开的子节点从默认展开节点列表数组中移除this.expandKey = this.expandKey.filter(function (item) {return item !== childNodes[i].data.catId;});}}this.expandKey = this.expandKey.filter(function (item) {return item !== data.catId;});},},created() {this.getCategoryTree();},mounted() {},beforeCreate() {},beforeMount() {},beforeUpdate() {},updated() {},beforeDestroy() {},destroyed() {},activated() {},};</script><style lang='scss' scoped></style>

新增分类记录

前端

使用Element-Ui对话框组件作为点击新增弹出的对话框

对话框组件

对话框的打开由按钮的

visible.sync属性控制,双向绑定dialogVisible属性值,该属性值变成true对话框就会自动弹出,变成false就会自动关闭,直接把这个组件el-dialog放在template标签中,但是该元素要求template标签中必须有一个根元素div标签,该组件需要放在该div中;对话框绑定了一个:before-close事件,在对话框关闭前会调用handleClose方法

弹出框需要填写表单的使用嵌套表单的对话框组件

el-form组件是在对话框组件中添加的一个表单组件

一般对话框的自动关闭功能和表单的提交都放在确定按钮的点击事件完成

xxxxxxxxxx<!-- Form --><el-button type="text" @click="dialogFormVisible = true">打开嵌套表单的 Dialog</el-button><el-dialog title="收货地址" :visible.sync="dialogFormVisible"><el-form :model="form"><el-form-item label="活动名称" :label-width="formLabelWidth"><el-input v-model="form.name" autocomplete="off"></el-input></el-form-item><el-form-item label="活动区域" :label-width="formLabelWidth"><el-select v-model="form.region" placeholder="请选择活动区域"><el-option label="区域一" value="shanghai"></el-option><el-option label="区域二" value="beijing"></el-option></el-select></el-form-item></el-form><div slot="footer" class="dialog-footer"><el-button @click="dialogFormVisible = false">取 消</el-button><el-button type="primary" @click="">确 定</el-button></div></el-dialog><script>export default {data() {return {dialogFormVisible: false,form: {name: '',region: '',date1: '',date2: '',delivery: false,type: [],resource: '',desc: ''},formLabelWidth: '120px'};}};</script>表单组件

表单组件el-form的单向绑定属性model绑定的是表单内容对应参数目标封装对象,比如商品分类对象category

el-form-item标签是每个表单元素,里面可以填充各种表单类型,label属性是该项表单的名字,label-width属性是表单的宽度el-input标签是文本输入框,v-model是双向绑定,绑定的是表单对象category的某个属性,比如category.name绑定的是对象category的name属性,默认值一般给空串el-button标签是按钮,表单有默认的提交按钮,但是可以不用,一般是用对话框的确定按钮来提交表单

xxxxxxxxxx<el-form ref="form" :model="category" label-width="80px"><el-form-item label="分类名称"><el-input v-model="category.name"></el-input></el-form-item><el-form-item label="活动区域"><el-select v-model="form.region" placeholder="请选择活动区域"><el-option label="区域一" value="shanghai"></el-option><el-option label="区域二" value="beijing"></el-option></el-select></el-form-item><el-form-item label="活动时间"><el-col :span="11"><el-date-picker type="date" placeholder="选择日期" v-model="form.date1" style="width: 100%;"></el-date-picker></el-col><el-col class="line" :span="2">-</el-col><el-col :span="11"><el-time-picker placeholder="选择时间" v-model="form.date2" style="width: 100%;"></el-time-picker></el-col></el-form-item><el-form-item label="即时配送"><el-switch v-model="form.delivery"></el-switch></el-form-item><el-form-item label="活动性质"><el-checkbox-group v-model="form.type"><el-checkbox label="美食/餐厅线上活动" name="type"></el-checkbox><el-checkbox label="地推活动" name="type"></el-checkbox><el-checkbox label="线下主题活动" name="type"></el-checkbox><el-checkbox label="单纯品牌曝光" name="type"></el-checkbox></el-checkbox-group></el-form-item><el-form-item label="特殊资源"><el-radio-group v-model="form.resource"><el-radio label="线上品牌商赞助"></el-radio><el-radio label="线下场地免费"></el-radio></el-radio-group></el-form-item><el-form-item label="活动形式"><el-input type="textarea" v-model="form.desc"></el-input></el-form-item><el-form-item><el-button type="primary" @click="onSubmit">立即创建</el-button><el-button>取消</el-button></el-form-item></el-form><script>export default {data() {return {category: {name: '',region: '',date1: '',date2: '',delivery: false,type: [],resource: '',desc: ''}}},methods: {onSubmit() {console.log('submit!');}}}</script>业务逻辑

点击树形组件的Append按钮触发append方法调出对话框并为商品类赋值除了分类名字的其他所有属性,添加一个商品分类需要添加的字段信息有名字、父分类id、分类级别、排序、图标、商品计量单位【product_unit】、商品数量

商品数量通过其他方式进行累计添加,这里不管

注意前端的封装对象的属性名要和后端实体类的属性名相同

商品分类的父分类id通过树形组件的节点append按钮自动传参的data的catId属性获得

注意append点击调用的append方法自动传参的data中已经包含了服务器父分类对象的完整对应数据

分类层级可以通过父分类的层级自加1获得

后端传过来的数据被解析成对象,属性值是字符串,如果需要做数学运算可以使用

字符串*1转换成数字再做数学运算排序使用默认值0、逻辑删除标识使用默认值1表示存在、

图标和商品计量单位和名字一样都通过对话框添加

对话框的确定按钮绑定单机事件触发saveCategory函数发送post请求提交表单参数保存记录

响应成功弹框提示信息并关闭对话框,将分类对象category恢复成初始配置,刷新属性列表数据,同时注意用户点击Append按钮一般是不会展开子目录的,为了观察到节点添加效果,这里需要自动将父节点展开

category恢复成初始配置的方式如下:抽取初始设置作为常量,对话框每次关闭或者新增时进行初始化,通过js方法

this.category = Object.assign({}, INITCATEGORY);将两个对象合并成一个新对象赋值给category由于每次打开对话框都会重新初始化category,不会存在对话框回显混乱的问题

xxxxxxxxxx<script>//定义一个常量作为category对象的初始化配置const INITCATEGORY = {catId: null,name: "",parentCid: 0,catLevel: 1,showStatus: 1,sort: 0,icon: "",productUnit: "",};export default {components: {},props: {},data() {return {isAdd: true,dialogFormVisible: false,//category设置为一个空对象,等待处理赋值默认值category: {},};},methods: {//点击新增节点弹出对话框,给部分属性值赋值append(data) {this.isAdd = true//弹出新增分类对分类数据进行初始化this.category = Object.assign({}, INITCATEGORY)this.dialogFormVisible = truethis.category.parentCid = data.catIdthis.category.catLevel = data.catLevel * 1 + 1},//保存新增商品分类记录saveCategory() {this.$http({url: this.$http.adornUrl("/product/category/save"),method: "post",data: this.$http.adornData(this.category, false),}).then(({ data }) => {this.getCategoryTree();this.dialogFormVisible = false;//自动展开父目录this.expandKey = [this.expandKey, this.category.parentCid];//新增商品分类成功后再次对商品分类数据进行初始化this.category = Object.assign({}, INITCATEGORY);this.$message({type: "success",message: "新增商品分类成功!",});});},},};</script>

后端接口

业务逻辑

使用renren-generator逆向工程生成的save方法使用@RequestBody注解将json数据自动转成商品实体类,根据实体类使用自增主键保存新增商品记录

注意前端提交对象的属性名要和后端实体类的属性名一一对应

修改分类记录

前端

业务逻辑

修改分类记录的对话框复用添加分类数据的对话框,根据新增按钮或者修改按钮设置isAdd值为true或者false,由此判断对话框标题并以此确定点击确认后是修改分类还是新增分类,且要对数据实时进行回显

回显过程中为了避免用户在列表界面停留很久,其他用户已经在该期间对数据进行了修改而重复修改的问题,回显的数据专门请求根据catId查询单个分类记录的接口获取最新数据进行回显

确定按钮要增加判断条件,如果是修改就调用修改分类的方法发起修改请求,如果是新增就调用新增分类的方法发起修改请求,这里可以用当前分类记录是否含有catId字段作为修改还是新增的判据【判断策略经过考虑后换成根据isAdd判断执行新增分类还是执行修改分类比较简洁和优雅】

修改分类的数据只会修改部分分类的名字,图标和计量单位,可以使用category的解构表达式只获取这三个外加一个catId解构以后构建新的只包含这四个参数的对象

根据主键修改记录,如果属性值为null就会跳过修改

请求成功响应弹窗提示信息,重新请求树形列表数据,关闭对话框,

在修改过程中鼠标稍微往外一滑一点,对话框就会自动消失,对话框的属性中有个

close-on-click-modal属性,表示是否可以通过点击modal来关闭对话框,默认值为true,需要设置成false来禁止对话框的随意点击消失,属性值需要布尔值,如果非要写字符串使用单向绑定即可

后端

业务逻辑

renren-generator逆向工程生成了对单个分类记录的查询方法info,直接调用接口即可

renren-generator的逆向工程生成了对单个分类记录的修改方法update,直接调用接口即可

节点拖拽

树形组件的节点拖拽后要满足三次商品分类结构,树形节点拖拽上下移动并和排序字段进行绑定

前端拖拽效果

业务逻辑

element-ui的树形列表控件中有一个

draggable属性,意思是是否开启节点拖拽功能,属性值是布尔类型,默认值为false,将其设置为true就能开启节点的拖拽功能【不能写成单向绑定会报错,直接单加一个draggable属性即可】但是原始的节点拖拽功能很自由,同级节点之间可以更换先后顺序,也可以让其中一个节点变成另一个节点的子节点,演变成超过三层分类,所以需要对拖拽功能进行限制

树形控件的另一个属性

allow-drop,作用是拖拽时触发allowDrop函数判断目标节点能否被放置,allow-drop是一个函数Function(draggingNode, dropNode, type)【这个函数就是allowDrop】,函数有三个参数,draggingNode是当前正在被拖拽的节点,type是当前节点可以放在哪些位置,dropNode是目标节点;返回布尔类型,该函数返回false时,任意节点的拖拽效果都是被禁止的type的值可以取三个,

prev指可以放在目标节点前面、inner指可以放在目标节点里面、next指可以放在目标节点后面,这个参数是根据被拖拽节点的位置和目标节点的位置关系判断的,目标节点是鼠标滑动时最后一次经过的哪个节点,type就是相对于最后划过的哪个节点判断的allowDrop函数的拉拽判断逻辑

allowDrop函数会传参三个参数,意义分别是

draggingNode是当前正在被拖拽的节点,以后统称当前节点;当前节点参数中的level属性会随着层级变化而持续变化,对应的父节点的childNodes数组中也会实时更新新增的节点,而且保持节点顺序,就是树形组件中所有的节点数据都是实时的,数据库原始数据不会变化

dropNode是拖拽过程中鼠标最后划过的节点,以后统称目标节点type是当前节点的最终位置与目标节点的关系,inner表示最终位置在目标节点里面,prev表示在目标节点前一个,next表示在目标节点后一个

allowDrop函数通过逻辑判断返回布尔类型的值,true表示可以拖拽,false表示不能拖拽

判断当前节点能否拖拽到目标位置的逻辑是,以当前节点为根的子树的深度加上目标位置父节点的层级要小于等于三级分类的最大层级深度即3,即拖拽后的节点层级仍然要满足三层分类效果

实现是定义一个变量maxLevel,对当前节点进行的所有子节点进行递归遍历,取出所有子节点中的最大层级存入变量maxLevel,最大层级减去当前节点的层级加1就是当前节点为根的子树的深度;因为在拖拽过程中,allowDrop函数会被频繁调用,会不停地执行对当前节点子树的遍历,因此在对子树遍历以前,用一个变量将当前节点缓存起来,只要变量没有被更新,maxLevel中的最大层级数就是当前节点的子树最大层级,由此减少大量的重复无效计算【减少重复计算是本人独立优化】

拿到当前节点的子树深度根据type是否inner类型进行判断,

如果是inner类型说明目标节点就是目标位置的父节点,子树深度加目标节点的层级之和小于等于3目标位置就合法

如果不是inner类型说明目标节点的父节点才是目标位置当前节点的父节点,子树深度加上目标节点的父节点的层级之和小于等于3目标位置就合法

代码实现

xxxxxxxxxx<!--树形组件部分,和拖拽相关的属性为draggable和:allow-drop="allowDrop";draggable默认是关闭的,写上就表示开始,给其赋值true反而报错--><el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkboxnode-key="catId":default-expanded-keys="expandKey"@node-expand="handleNodeExpand"@node-collapse="handleNodeCollapse"draggable:allow-drop="allowDrop">methods:{//判断一个节点是否能被拖拽到指定指定位置,draggingNode是被拖拽节点、dropNode是目标节点,即鼠标最后经过的节点//type是当前正在被拖拽的节点与目标节点间的关系allowDrop(draggingNode, dropNode, type){//一、整体逻辑当前节点拖拽后于其父节点构成的节点总层数必须小于等于3//判断当前节点的深度是否已经保存到isDraggingNode对象中了,如果保存了就不要再求当前节点的深度了,//this.nodeMaxLevel保存的就是当前节点的最大层级,节省拖拽过程重复调用子树遍历浪费系统性能if(this.isDraggingNode!=draggingNode){this.isDraggingNode=draggingNode//1--求当前节点的子树深度//初始化当前节点层级this.nodeMaxLevel=draggingNode.level//计算当前节点子树的最大levle值,结果保存在this.nodeMaxLevel中this.countCurNodeMaxLevel(draggingNode)}//当前节点子树深度let draggingNodeTreeDeep=this.nodeMaxLevel-draggingNode.level+1//如果type类型是inner,当前节点深度和目标节点深度之和要小于等于3,//否则说明当前节点是平移或者平移到其他目录,这种情况计算当前节点深度和目标节点的父节点层级之和小于等于3//这两种情况都可以总结为目标节点和移动后的父节点构成的树的最大深度小于等于3if(type=='inner'){return draggingNodeTreeDeep+dropNode.level <= 3}else{return draggingNodeTreeDeep+dropNode.level-1 <= 3}},//求一个节点的最大目录层级,相当于遍历所有的子节点获取子节点的最大levelcountCurNodeMaxLevel(node){//判断一个节点是否有子节点,当前节点没有子节点就使用当前节点的层级作为返回值if(node.childNodes!=null && node.childNodes.length>0){for(let i=0;i<node.childNodes.length;i++){if(node.childNodes[i].level>this.nodeMaxLevel){this.nodeMaxLevel=node.childNodes[i].level}//对每个子节点递归求最大目录层级this.countCurNodeMaxLevel(node.childNodes[i])}}}}

分类数据拖拽关联

拖拽效果会引起商品分类的parent_cid【父ID】、level【层级】、sort【排序】三个字段变化,进行一次拖拽效果就要给后台发送一次对当前节点和同级节点【同级节点的sort字段发生了变化】的更新请求修改对应的字段,子节点只需要处理层级变化,当前节点在什么位置和子节点没什么关系,但是当前子节点的层级发生变化,所有子节点的层级也会相应的发生变化,也需要对所有子节点的层级进行更新,所有的节点记录可以一次性提交,数组中的对象只需要设置需要修改的字段,SpringBoot在处理的时候会自动把不需要修改的字段全部置为null,相应的数据库表的数据也也会修改不为null的字段

element-ui的树形控件中有一个拖拽结束事件

node-drag-end【拖拽结束不管是否成功都会触发】和一个拖拽成功事件node-drop【拖拽成功完成触发事件】,拖拽成功完成触发事件的回调函数handleDrop一共有四个参数,分别是被拖拽的当前节点、目标节点、type【目标位置相对于目标节点的相对位置before、after、inner、最后一个参数是整个事件对象】目标节点的parent保存了中的children保存了目标节点的全部数据,即便目标节点是一级节点其父不是节点而是所有一级节点的数组也同样在parent中保存了全部一级节点的信息,但是当前节点是一级节点或者变成了一级节点parent字段是不会有值的

树形列表一级节点的父是一个数组,不再是某个分类了,父id此时会变成

undefined【这里可以用更优雅的断路写法pCid = dropNode.parent.data.catId || 0;】业务逻辑

分插入到目标节点内部还是目标节点前后获取到当前节点的父节点,父节点是通过目标节点获取的,如果当前节点是一级节点,当前节点的parent属性是

undefined,但是目标节点即使是一级节点,parent属性仍然是包含所有兄弟节点的数组创建数组

this.updateNodesAfterDrop用于封装要修改的商品记录,使用this.updateNodesAfterDrop.push(追加对象)来向数组中追加要修改的记录对拖拽后的当前节点的兄弟节点进行遍历,对非当前节点的兄弟节点,统一修改排序字段为数组索引;对当前节点修改父节点id,排序,层级【层级使用当前节点实时变化的level属性】;如果当前节点的层级发生变化,对当前节点为根的子树所有节点的层级字段以节点的level属性为标准递归修改;修改了的记录全部追加到数组中等待向后端接口发起请求

注意所有对象都追加catId属性获取分类记录的主键作为修改数据库数据的查找条件【注意节点的id和分类记录的原始catId是不一样的,不要写错了】

当前节点拖拽到一级节点获取父节点的id为undefined,在js中和0做短路或运算将undefined处理成0即可【js中的短路或运算见附录】

向后端接口发送post请求更新数据库字段,响应成功以后将更新数组清空

刷新页面【不刷新其实也可以】,向默认展开的数组中添加当前节点的父节点

代码实现

xxxxxxxxxx树形组件<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkboxnode-key="catId":default-expanded-keys="expandKey"@node-expand="handleNodeExpand"@node-collapse="handleNodeCollapse"draggable:allow-drop="allowDrop"@node-drop="handleDrop">handleDrop(draggingNode, dropNode, dropType, ev) {/*一、整体思路:1. 获取当前节点的父节点,通过父节点的获取到拖拽结束后的所有子节点2. 对子节点进行遍历,目标是凡是涉及到数据字段变化的节点记录全部更新,目标节点的父节点下的同级子节点的排序字段全部更新【获取子节点的id和更新排序】目标节点的更新内容包括排序、父节点id、层级【获取节点的id和更新排序、父节点id、层级】目标节点层级发生变化,目标节点为根的子树上所有节点有且仅有层级都会发生变化【子节点的id和更新层级】[这里不考虑目标节点的父节点的子节点sort字段变化,因为不影响排序,后续该节点下发生节点移入会自动更新]3. 更新方式为一次传参整个数组,每个对象根据属性名自动封装,没有的属性值设置为null,更新时自动忽略*///1. 获取当前节点拖拽后父节点下的所有子节点//定义当前节点的父节点下的所有子节点let brosOfDraggingNode=null;let pCidOfDraggingNode=0;//如果当前节点的父节点是目标节点的父节点if(dropType == "before" || dropType=="after"){//目标节点即使是一级节点dropNode.parent.childNodes也是所有一级节点brosOfDraggingNode=dropNode.parent.childNodespCidOfDraggingNode=(dropNode.parent.data.catId || 0)}else{//当前节点的父节点是目标节点brosOfDraggingNode=dropNode.childNodespCidOfDraggingNode=dropNode.data.catId}console.log("同级数据:",brosOfDraggingNode,pCidOfDraggingNode)//2. 对所有兄弟节点进行遍历,至少有一个子节点,直接遍历即可for(let i=0;i<brosOfDraggingNode.length;i++){//如果子节点是当前节点,将要修改的数据封装成对象封装到this.updateNodesAfterDro中等待发起更新请求//注意节点的id不一定是分类数据的catId,一定要看好了let curNode=brosOfDraggingNode[i]let curNodeData=brosOfDraggingNode[i].dataif(curNodeData.catId==draggingNode.data.catId){let catLevelOfDraggingNode = draggingNode.data.catLevel//如果当前节点的层级发生变化if(curNode.level!=catLevelOfDraggingNode){//当前节点的层级需要更新catLevelOfDraggingNode=curNode.level//对当前节点的所有子节点递归更改层级this.updateChildNodesLevel(curNode)}this.updateNodesAfterDrop.push({catId: curNodeData.catId,sort: i,parentCid: pCidOfDraggingNode,catLevel: catLevelOfDraggingNode})}else{this.updateNodesAfterDrop.push({catId: curNodeData.catId,sort: i})}}//console.log("tree drop: ", draggingNode,dropNode, dropType);console.log(this.updateNodesAfterDrop)},//更新一个节点下所有节点的层级updateChildNodesLevel(node){if(node.childNodes.length>0){for(let i=0;i<node.childNodes.length;i++){let curNode=node.childNodes[i]this.updateNodesAfterDrop.push({catId: curNode.data.catId,catLevel: curNode.level})this.updateChildNodesLevel(curNode)}}},优化

为了避免点击添加不小心拖动节点导致拖动逻辑执行,在界面添加一个拖动开关,只有开启拖动开关的时候才能进行拖动

开关组件

用开关组件双向绑定变量

draggable,树形组件单向绑定draggablexxxxxxxxxx<el-switchv-model="value"active-color="#13ce66"inactive-color="#ff4949"active-text="按月付费"inactive-text="按年付费"></el-switch><script>export default {data() {return {value: true}}};</script>配置实例

xxxxxxxxxx开关组件<el-header height="30px"><div el-row><el-col :span="24" :offset="11"><div class="grid-content bg-purple-dark">   <el-switchv-model="draggable"active-icon-class="el-icon-d-caret"width="30"></el-switch></div></el-col></div></el-header>树形组件<el-tree:data="categoryTree":props="defaultProps":expand-on-click-node="false"show-checkboxnode-key="catId":default-expanded-keys="expandKey"@node-expand="handleNodeExpand"@node-collapse="handleNodeCollapse":draggable="draggable":allow-drop="allowDrop"@node-drop="handleDrop">

多次批量拖拽一次提交同步雷神的实现有大问题

根本没有考虑对同一个当前节点的多次拖拽导致的单次提交数据重复修改的问题,前端学的不太全,这里以后看有没有类似HashMap的前端数据结构,只保留同一个节点最后的更新数据,避免重复修改问题;同时还有锁的问题,可能存在多用户同时修改的情况都没有考虑

拖拽一次更新一次数据库确实不合理,以后看有没有什么优化手段

尝试了一下,添加了批次拖拽的功能,就是添加一个保存更改的按钮,将所有节点包括重复更改的节点数据一次性点击保存更改进行提交,把提交代码放到了保存更改的按钮点击事件中去了;额外增加了关闭拖拽的数据保存提醒功能

现在功能一切正常,有bug遇到再说,仍然存在同一个当前节点和兄弟节点重复更新的情况,只是目前看起来没啥bug,功能仍然正常

后端

业务逻辑

后端添加一个批量修改商品分类数据的接口,很简单,用List集合直接接收,通过

updateBatchById方法批量修改数据;

批量删除节点

树形列表有选中框

show-checkbox设置为true时,树形组件有一个内部方法getCheckedNodes(leafOnly, includeHalfChecked),该方法返回当前被选中的节点组成的数组,组价内部的方法需要通过组件进行调用,获取组件需要给指定组件添加ref=tree属性,即给组件起一个名字作为唯一标识,在方法中通过this.$refs.tree.filter(val)进行调用【this表示vue实例,this.$ref是当前实例中的所有组件,this.$refs.tree是拿到组件中名为tree的组件,this.$refs.tree.filter(val)表示调用tree组件内部的filter方法】

前端

getCheckedNodes(leafOnly, includeHalfChecked)方法参数

leafOnly是是否只返回叶子节点【?三级分类全被选中,二级分类是否包含?默认是全返回,包含二级一级节点】,默认是false参数

includeHalfChecked)是否包含半选节点,就是子节点没有被全部选中父节点的状态,默认是false返回值是一个包含选中节点的数组

对数组每个元素进行处理并将处理结果对应返回成一个新的数组

获取选中树形控件的节点名称

let menuName = this.$refs.menuTree.getCheckedNodes().map(node => node.name);获取选中树形的节点id:

let catIds = this.$refs.menuTree.getCheckedNodes().map(node => node.catId)本质都是一样的,数组的map方法遍历原数组中的所有元素,将对每个元素的处理结果存入一个相同大小的信数组

业务逻辑

给一个删除按钮,删除按钮单向绑定一个变量,该变量根据树形控件的节点复选框点击事件进行判断,通过调用树形控件内置的

this.$refs.menuTree.getCheckedNodes()方法获取到被选中的节点,如果选中节点数为0,删除按钮禁用;如果有被选中的节点,删除按钮可用删除的逻辑是从树形控件内置方法中获取到选中节点的catId,将catId数组直接传到后端进行删除,后端删除也只需要id的Long类型数组

后端

业务逻辑

复用后端批量逻辑删除的接口,此前单个删除使用的是批量删除接口,根据商品分类的id批量删除商品分类记录

商品品牌管理

品牌表对应数据库

mall_pms的pms_brand表,字段内容包括品牌id、名字、logo、介绍、逻辑删除标志位、检索首字母、品牌排序后台管理系统的列表功能直接使用renren-generator逆向工程的前端标准组价,不再自己实现,renren逆向生成也是基于element-ui的组件实现的

准备工作

后台前端界面新增商品菜单--品牌管理,路由规则

product/brand直接使用逆向工程生成的商品组件代码,文件位置,后端product模块

src/views/modules/product/brand.vue【品牌列表】和src/views/modules/product/brand-add-or-update.vue【品牌的添加和修改组件】,直接把这两个文件复制到前端项目的路由规则目录src\views\modules\product下效果

生成过程中会自动将数据库的字段备注作为表头信息;没有新增和删除按钮是因为当前还没有做权限系统,默认当前用户是没有权限增删品牌的;按钮显示会调用

isAuth()方法判断用户是否拥有权限,没有权限直接v-if不显示对应的按钮isAuth方法的定义位置看是从哪儿导出的,全局搜索isAuth,即找到export关键字所在位置【实际位置在utils/index.js中】目前还没有涉及权限系统,让

isAuth方法返回为true关闭权限系统

列表功能

列表优化

显示状态给一个按钮,需要显示打开开关,不想显示关闭开关

开关的

active-value属性可以设置指定激活值,inactive-value属性设置指定不激活值,默认激活值是true,不激活值是false,指定的变量是数字需要使用单向绑定;而且设定以后开关变化对应双向绑定的值也会自动封装成指定值,不再使用true和false

自定义表格模板

element-ui表格通过

Scope.slot即vue中的卡槽机制给要修改的列el-table-column标签定义一个template模板【template标签】,其中的slot-scope属性的属性值scope中封装了当前列所在一整行的所有数据,在template中定义所有行的当前字段要展示的内容,这里面可以继续放element-ui的组件表格结构为el-table>>el-table-column>>template

scope.row是当前行后端响应的单个记录的全部数据,这个数据可以看做就是后端传过来的原始数据,双向绑定的变量会实时变更数据的值,这个scope.row可以作为参数直接传递到组件调用的方法中去

xxxxxxxxxx<template><el-table :data="tableData" style="width: 100%"><el-table-column label="日期" width="180"><template slot-scope="scope"><i class="el-icon-time"></i><span style="margin-left: 10px"></span></template></el-table-column><el-table-column label="姓名" width="180"><template slot-scope="scope"><el-popover trigger="hover" placement="top"><p>姓名: </p><p>住址: </p><div slot="reference" class="name-wrapper"><el-tag size="medium"></el-tag></div></el-popover></template></el-table-column></el-table></template><script>export default {data() {return {tableData: [{date: '2016-05-02',name: '王小虎',address: '上海市普陀区金沙江路 1518 弄'}]}},methods: {handleEdit(index, row) {console.log(index, row);},handleDelete(index, row) {console.log(index, row);}}}</script>

对话框

优化新增品牌对话框

对话框组件实际上是从当前目录的

brand-add-or-update.vue文件中导入的【也就是后端生成的另一个文件】,导入语句import AddOrUpdate from "./brand-add-or-update";,组件的使用通过对应的add-or-update【引用组件的语法规则】标签,组件使用的变量值已经提前生成在变量中了,对对话框组件修改直接去文件./brand-add-or-update中修改将显示状态换成开关组件

通过开关的change事件可以监听组件的变化,自动传参组件的当前状态,给服务器发送数据修改品牌的显示状态,除此以外

el-form表单的宽度调整el-form有一个label-width属性,规定了表单项中每个表单名称占用的宽度,改为140px品牌logo改成一个文件上传框

绑定的值应该是文件上传以后返回的地址

上传框使用Upload组件,从这里开始需要涉及到图片文件存储的问题

【Upload组件】

action是文件上传的地址,file-list是文件列表展示,

xxxxxxxxxx<el-uploadclass="upload-demo"action="https://jsonplaceholder.typicode.com/posts/":on-change="handleChange":file-list="fileList"><el-button size="small" type="primary">点击上传</el-button><div slot="tip" class="el-upload__tip">只能上传jpg/png文件,且不超过500kb</div></el-upload><script>export default {data() {return {fileList: [{name: 'food.jpeg',url: 'https://fuss10.elemecdn.com/3/63/4e7f3a15429bfda99bce42a18cdd1jpeg.jpeg?imageMogr2/thumbnail/360x360/format/webp/quality/100'}, {name: 'food2.jpeg',url: 'https://fuss10.elemecdn.com/3/63/4e7f3a15429bfda99bce42a18cdd1jpeg.jpeg?imageMogr2/thumbnail/360x360/format/webp/quality/100'}]};},methods: {handleChange(file, fileList) {this.fileList = fileList.slice(-3);}}}</script>将文件上传组件upload上传到项目

src/components目录下由于项目中会多次用到文件上传组件以及签名请求,特意将组件和请求单独封装放在

src/components组件包含一个多文件上传组件和单文件上传组件和一个获取签名的模块【单文件上传组件】

action是文件要上传位置的域名,注意就是用http协议

文件点击点击上传按钮会触发before-upload事件,会调用beforeUpload方法向服务端获取签名

上传成功以后会将响应的图片地址放在fileList数组的对应元素的url属性并在img标签回显对应的图片

上传前将文件名变成了UUID+文件名防止图片重复,同样的名字会直接进行覆盖

xxxxxxxxxx<template><div><el-uploadaction="http://gulimall.oss-cn-shanghai.aliyuncs.com":data="dataObj"list-type="picture":multiple="false" :show-file-list="showFileList":file-list="fileList":before-upload="beforeUpload":on-remove="handleRemove":on-success="handleUploadSuccess":on-preview="handlePreview"><el-button size="small" type="primary">点击上传</el-button><div slot="tip" class="el-upload__tip">只能上传jpg/png文件,且不超过10MB</div></el-upload><el-dialog :visible.sync="dialogVisible"><img width="100%" :src="fileList[0].url" alt=""></el-dialog></div></template><script>import {policy} from './policy'import { getUUID } from '@/utils'export default {name: 'singleUpload',props: {value: String},computed: {imageUrl() {return this.value;},imageName() {if (this.value != null && this.value !== '') {return this.value.substr(this.value.lastIndexOf("/") + 1);} else {return null;}},fileList() {return [{name: this.imageName,url: this.imageUrl}]},showFileList: {get: function () {return this.value !== null && this.value !== ''&& this.value!==undefined;},set: function (newValue) {}}},data() {return {dataObj: {policy: '',signature: '',key: '',ossaccessKeyId: '',dir: '',host: '',// callback:'',},dialogVisible: false};},methods: {emitInput(val) {this.$emit('input', val)},handleRemove(file, fileList) {this.emitInput('');},handlePreview(file) {this.dialogVisible = true;},beforeUpload(file) {let _self = this;return new Promise((resolve, reject) => {policy().then(response => {_self.dataObj.policy = response.data.policy;_self.dataObj.signature = response.data.signature;_self.dataObj.ossaccessKeyId = response.data.accessid;_self.dataObj.key = response.data.dir +getUUID()+'_${filename}';_self.dataObj.dir = response.data.dir;_self.dataObj.host = response.data.host;resolve(true)}).catch(err => {reject(false)})})},handleUploadSuccess(res, file) {console.log("上传成功...")this.showFileList = true;this.fileList.pop();this.fileList.push({name: file.name, url: this.dataObj.host + '/' + this.dataObj.key.replace("${filename}",file.name) });this.emitInput(this.fileList[0].url);}}}</script><style></style>【引用单文件组件】

xxxxxxxxxx<template><div><single-upload></single-upload></div></template><script>import SingleUpload from '@/Components/upload/singleUpload'export default {//components:{SingleUpload:SingleUpload},//前后名字相同,可以只写一个,标签名字是根据第一个名字进行引用的components:{SingleUpload},}</script>【policy模块】

这个是浏览器请求服务端签名的请求模块

xxxxxxxxxximport http from '@/utils/httpRequest.js'export function policy() {return new Promise((resolve,reject)=>{http({url: http.adornUrl("/thirdparty/oss/policy"),method: "get",params: http.adornParams({})}).then(({ data }) => {resolve(data);})});}【前端直接请求OSS服务器】

前端直接请求OSS服务器也会存在跨域问题,需要在OSS控制台设置允许自己的浏览器的跨域请求【文档搜索修改CORS】,在bucket的基础设置中的设置跨域访问

注意事项

来源设置成自己的前端所在的域

允许post请求

允许Header设置成

*

文件存储方案

类似图片之类的文件存储,本分布式项目选择云服务商提供的对象服务,优点是搭建简单,前期成本低

单体应用

单体应用直接将文件上传到后端服务器,用户需要再直接响应给用户

集群应用

用户上传文件负载均衡到某一台服务器上,用户下次请求被负载均衡到别的服务器就找不到对应的文件了,需要额外进行优化

解决办法是,无论文件从哪个服务器上传,最后都统一存在一台文件存储服务器上,这样无论哪一台服务器响应文件数据都从这一台文件存储服务器上获取

七牛云有免费10G的云存储容量

该文件存储服务器可以自己搭建【使用FastDFS、vsftpd搭建】,搭建成本和前期费用高

也可以使用第三方的云存储服务功能【阿里云对象存储、七牛云】,即开即用,按量计费

业务逻辑

由于业务需要,需要引入阿里云对象存储服务来保存品牌的上传信息

在common中引入alicloud-oss starter依赖

文件存储方式

方式一:用户文件上传,服务端拿到用户的文件流,使用Java代码将文件上传到OSS

但是这种方式不好,文件需要经过用户自己的服务器,还会经过网关,消耗系统性能,用户量大的情况下会带来瓶颈

但是安全,因为账号密码由服务器自己控制

让用户直传阿里云服务器需要将账号密码写在js代码中让浏览器直接发送请求给阿里云服务器,但是这种方式不安全,存在账号密码泄露的问题

人数一多服务器文件上传非常占用带宽,服务器就无法处理别的请求了

方式二:服务端签名后直传

上传前请求应用服务器获取防伪签名令牌,浏览器带着防伪令牌和文件直接访问阿里云服务器

用户上传前先向应用服务器请求上传策略、应用服务器使用阿里云的账号密码生成一个防伪签名,签名信息包括用户访问阿里云的授权令牌,文件上传到阿里云的哪个位置等信息,防伪签名中不含账号密码【和https非对称加密原理是一样的,请求由公钥加密,私钥解密;响应由私钥加密,公钥解密;公钥加密的内容公钥无法解密】,保证了服务器使用公钥加密的令牌只能被阿里云服务器的私钥进行解密,阿里云返回的数据即便能被泄露的公钥解密也无伤大雅,因为阿里云服务器已经实现了服务器的认证工作

第三方服务

本项目使用到多种第三方服务,包括对象存储颁发访问授权签名,短信验证码、第三方支付等服务;将这些服务专门整合到一个模块中统一处理

在品牌模块中仅实现OSS对象存储的签名直传功能

创建模块mall-third-party

web开发环境SpringMVC、OpenFeign远程调用功能、注册中心配置中心依赖common

将oss服务的依赖放在第三方服务中,不要放在common服务下,因为有些模块是不需要使用第三方服务的,放在common下每个服务都需要进行相应的配置,而且引入的renren-fast本身使用了oss服务,如果common引入oss会导致和renren-fast的发生版本冲突

注册中心、配置中心【命名空间】、服务名、服务端口号、

【使用配置中心的配置文件】

对应配置项

xxxxxxxxxxspring.cloud.nacos.config.server-addr=127.0.0.1:8848spring.cloud.nacos.config.namespace=d37d5dd6-2b25-45b3-8bf2-916e5ec92193spring.cloud.nacos.config.ext-config[0].data-id=oss.ymlspring.cloud.nacos.config.ext-config[0].group=DEFAULT_GROUP#配置指定配置文件动态刷新spring.cloud.nacos.config.ext-config[0].refresh=true根据官方文档最佳实战---服务端签名后直传编写服务端签名代码

浏览器请求服务端拿签名,浏览器拿到签名后将文件直传阿里云对象存储服务器

编写第三方模块OSS服务端签名直传签名颁发接口【签名逻辑为读取配置文件的OSS操作用户的keyId、KeySecret、bucket和endpoint,用LinkedHashMap封装操作用户ID、对由文件大小阈值、文件存储路径、签名有效时间、OssClient信息封装成的策略编码和服务端签名、文件存储路径、bucket对应host、和签名有效时间;】

配置网关对服务的路由策略

前端基于element-ui实现一个单文件上传组件,一个多文件上传组件,以及向应用服务器要签名的policy方法

这些组件放在

src/modules/update目录中

业务逻辑是前端选择图片后触发文件上传组件的

before-upload事件,调用方法向应用服务器第三方模块请求签名,并将签名信息封装到上传组件的data属性单向绑定的对象中,上传组件在该事件方法执行结束后才会自动请求组件中action对应的地址,传参data属性的对象【前端文件上传到OSS服务器的写法详见前端常用模块】,上传完毕后触发on-success事件执行对应的方法【自动传参file参数,file.name可以获取到文件的名字】按规律拼接图片访问链接并使用img标签对logo图片进行回显renren-fast-vue的element-ui版本好像不支持element-ui的el-image标签

对话框再优化

使用Element-ui的form表单的表单验证对表单提交内容进行验证,renren-fast-vue的表单验证功能只有基础的非空验证,无法对内容进行逻辑判断,使用element-ui对表单校验进一步优化

form表单的rules属性对表单内容进行校验

el-form表单的model属性把表单数据和对象进行绑定,用rules属性绑定表单的校验规则,rules的定义规则

rules也是Vue中定义的一个对象,name表示对表单绑定的对象的name属性的数据进行校验,校验可以设置多种校验规则,一个大括号就是一条校验规则,多条校验规则按顺序进行校验

required: true为非空检验,

message表示当前校验规则不满足对应的提示信息

trigger表示校验触发的时机,

trigger: 'blur'表示失焦的时候触发校验min是最小长度,max是最大长度

xxxxxxxxxxrules: {name: [{ required: true, message: '请输入活动名称', trigger: 'blur' },{ min: 3, max: 5, message: '长度在 3 到 5 个字符', trigger: 'blur' }],region: [{ required: true, message: '请选择活动区域', trigger: 'change' }],date1: [{ type: 'date', required: true, message: '请选择日期', trigger: 'change' }],date2: [{ type: 'date', required: true, message: '请选择时间', trigger: 'change' }],type: [{ type: 'array', required: true, message: '请至少选择一个活动性质', trigger: 'change' }],resource: [{ required: true, message: '请选择活动资源', trigger: 'change' }],desc: [{ required: true, message: '请填写活动形式', trigger: 'blur' }]}自定义校验规则

每个属性的单条校验规则可以写一个validator属性,属性值为对应的方法名;调用校验规则时会自动传参rule校验规则、value表单当前接收的值、callback是校验成功失败以后的回调,callback不传参就表示校验成功,传参error对象表单校验就会显示对应的错误信息

validatePass可以以匿名方法的方式写在rules中,自定义校验规则可以和普通的校验规则混写,依然是按照顺序依次校验

注意callback如果没执行,表单无法进行提交

xxxxxxxxxxvar validatePass = (rule, value, callback) => {if (value === '') {callback(new Error('请输入密码'));} else {if (this.ruleForm.checkPass !== '') {this.$refs.ruleForm.validateField('checkPass');}callback();}};return {ruleForm: {pass: '',checkPass: '',age: ''},rules: {pass: [{ validator: validatePass, trigger: 'blur' }]}};表单额外增加的校验逻辑

检索首字母只能是一个字母

排序字段只能是数字,且必须是大于等于0的整数,可以这样写: !/^[0-9]*$/.test(value)

前端校验后后端还要再次校验【比如对一些攻击,只要知道接口的请求参数类型不使用浏览器使用postman发送请求,参数就想怎么输就怎么输了,前端校验防君子,后端校验防小人】

实例

对

firstLetter和sort属性设置校验规则xxxxxxxxxxfirstLetter: [{ required: true, message: "检索首字母不能为空", trigger: "blur" },{validator:(rule,value,callback)=>{if(!/^[a-zA-Z]$/.test(value)){callback(new Error("检索首字母必须为a-z的一个小写或大写字母"))}callback()}},],sort: [{ required: true, message: "排序不能为空", trigger: "blur" },{validator:(rule,value,callback)=>{if(!/^[0-9]*$/.test(value)){callback(new Error("排序必须填写大于0的整数"))}callback()}},],

form表单数据后端校验

使用JSR303【Java Specification Requests,即Java规范提案】,JSR303规定了数据校验的相关标准,在SpringBoot中对应实体类的属性值上标注注解来对属性值进行约束

name字段不能为空,也不能为单个空格字符

logo字段不能为空且必须是合法的url地址,但是可以是空格字符串

检索首字母不能为空且必须为单个字母

排序不能为空且必须为非负整数

后端对校验异常进行统一全局处理

开发过程中只有有问题,就大胆地将异常抛出,统一使用

@Controller+@ExceptionHandler进行全局异常处理,系统会返回给前端各种状态码,前端就能根据状态码和公司规范文档判断到底是什么问题错误码和错误信息规范

错误码定义规则为5位数字

前两位表示业务场景,最后三位表示错误码,例如10001,10:通用 001:系统未知异常

维护错误码后需要维护错误描述,将错误码和错误描述定义为枚举形式

错误码列表

10:通用 001:参数格式错误

11:商品

12:订单

13:购物车

14:物流

在common包下定义异常状态码和信息的枚举类StatusCode,在商品模块创建对校验异常的统一处理

【异常枚举类】

xxxxxxxxxxpublic enum StatusCode {UNKNOWN_EXCEPTION(10000,"系统未知异常"),VALID_EXCEPTION(10001,"参数格式校验失败"),;private int code;private String msg;StatusCode(int code,String msg){this.code=code;this.msg=msg;}public int getCode() {return code;}public String getMsg() {return msg;}}【校验异常的统一处理】

xxxxxxxxxx(MethodArgumentNotValidException.class)public R handleValidException(MethodArgumentNotValidException e){//特定异常类型可以通过发生异常后对应异常的getClass方法获取log.error("数据校验错误:{},异常类型:{}",e.getMessage(),e.getClass());//1. bindingResult可以通过e.getBindingResult()获取BindingResult bindingResult = e.getBindingResult();//1. 准备封装错误校验信息的容器Map<String,String> bingErrors = new HashMap<>();//2. 获取所有的错误校验结果并封装进MapbindingResult.getFieldErrors().forEach(item->{//获取错误属性名字String field = item.getField();//获取对应错误属性的错误校验信息String msg = item.getDefaultMessage();bingErrors.put(field,msg);});return R.error(StatusCode.VALID_EXCEPTION.getCode(), StatusCode.VALID_EXCEPTION.getMsg()).put("data",bingErrors);}

JSR303分组校验

对于一个品牌实体类,新增品牌和修改品牌的参数很可能是不一样的,比如新增不需要携带品牌ID,但是修改必须要带品牌ID、新增品牌和修改品牌时品牌名都不能为空。但是此时实体类的校验规则只有一套,此时就需要使用JSR303分组校验功能

每一种校验注解都有一个

groups属性,group属性是一个接口【Classs<?>】数组,这个接口是自定义的接口,比如在包valid下创建两个接口AddGroup和UpdateGroup,这是两个空接口,标注在不同的校验注解中分别表示在新增的时候才调用新增的校验,修改的时候才调用修改的校验,只是作为一种校验组合的区分在控制器方法中进行区分如果一个校验规则新增和修改都需要校验,则在group属性同时指定

AddGroup和UpdateGroup两个接口实例:

xxxxxxxxxx("pms_brand")public class BrandEntity implements Serializable {private static final long serialVersionUID = 1L;/*** 品牌id*/(message = "品牌ID不能为空",groups = {UpdateGroup.class})private Long brandId;/*** 品牌名*/(message = "必须填写品牌名",groups = {AddGroup.class,UpdateGroup.class})private String name;/*** 品牌logo地址*/(message = "请输入合法的logo地址",groups = {AddGroup.class,UpdateGroup.class})(groups = {AddGroup.class})private String logo;/*** 介绍*/private String descript;/*** 显示状态[0-不显示;1-显示]*/private Integer showStatus;/*** 检索首字母*/(groups = {AddGroup.class})(regexp = "^[a-zA-Z]$",message = "检索首字母必须是一个字母",groups = {AddGroup.class,UpdateGroup.class})private String firstLetter;/*** 排序*/(value = 0,message = "排序数字必须大于等于0",groups = {AddGroup.class,UpdateGroup.class})(groups = {AddGroup.class})private Integer sort;}

制定好校验规则后在控制器方法中将原来validation中的校验注解换成spring框架提供的

@Validated注解,该注解中的value属性也是接口数组,即在其中指定校验分组实现多场景情况下的复杂校验

注意:

@validated如果指定了分组,那么Bean中只校验属于该分组注解标注的值是否合法,没有指定分组的注解不会进行校验,如果@validated没有标注group,就会校验bean中所有没有分组的校验注解,此时被分组的注解反而不会生效注意啊,因为空值情况下有专门的非空注解来进行校验,所以基本上注解是不会对空值情况还进行相应的校验,也就是会默认校验正确,因为一个实体类针对不同的操作比如新增和修改可能涉及到指定多组校验,此时某些字段修改时可能会提交修改也可能不会提交修改,此时分组内的校验规则没指定非空校验,此时就会默认触发对应有值情况下需要校验的规则返回为正确,这样能同时实现空值情况下不进行入参校验【或者说空值默认校验结果为真】,有值的情况下严格执行入参校验规则

实例:

xxxxxxxxxx("/save")//@RequiresPermissions("product:brand:save")public R save((AddGroup.class) BrandEntity brand){brandService.save(brand);return R.ok();}("/update")//@RequiresPermissions("product:brand:update")public R update((UpdateGroup.class) BrandEntity brand){brandService.updateById(brand);return R.ok();}

JSR303自定义校验注解

现有的校验注解可能无法满足需求,比如校验排序字段必须为非负整数,此时能想到使用

@Pattern注解使用正则表达式对字段进行校验,但是该字段类型为Integer类型,@Pattern注解不能使用在Integer类型上【正则只能校验字符串】,此时就需要考虑使用自定义校验注解了自定义校验的实现需要三步:编写一个自定义校验注解,编写一个自定义检验器,关联自定义校验器和自定义校验注解

自定义校验注解要求

一个自定义校验注解必须满足JSR303规范,必须包含3个属性

message、groups、payloadmessage是校验出错以后的默认提示消息去哪儿获取

groups是注解必须支持分组校验功能

payload是自定义校验注解还可以自定义一些负载信息

自定义校验注解必须标注指定的元信息数据【标注指定的注解并配置源信息数据】

@Target({METHOD,FIELD,ANNOTATION_TYPE,CONSTRACTOR,PARAMTER,TYPE_USE})@Target注解指定该注解可以标注的位置@Retention(RUNTIME)@Retention(RUNTIME)指定该注解运行时可被获取Constraint(validatedBy={})Constraint(validatedBy={})指定该注解关联的校验器,这个地方不指定就需要在系统初始化的时候进行指定@Repeatable(List.calss)@Repeatable(List.calss)表示该注解是一个可重复注解

自定义校验注解实例

自定义校验注解

xxxxxxxxxx// validatedBy要指定一个ConstraintValidator的子类数组,我们可以指定自定义校验器,// 以自定义校验器ListValueConstraintValidator为例// 一个校验器只能适配一种参数类型,如果还需要适配其他参数类型,需要再定义一个校验器,并在同一个自定义校验注解使用validatedBy属性// 进行多个校验器的关联,校验注解会自动根据注解标注参数的类型自动地选出对应类型的校验器进行校验(validatedBy = {ListValueConstraintValidator.class})({ElementType.METHOD, ElementType.FIELD, ElementType.ANNOTATION_TYPE, ElementType.CONSTRUCTOR, ElementType.PARAMETER, ElementType.TYPE_USE})(RetentionPolicy.RUNTIME)//可重复注解,ListValue.List是校验注解内部自定义的可重复注解容器(ListValue.List.class)public @interface ListValue {//JSR303规范中message消息都统一在validationMessages.properties//我们也可以创建一个和该文件名一样的文件,在其中写对应的消息,Spring找不到会自动到自定义的同名文件中查找//消息的属性名一般都使用注解全类名.messageString message() default "{com.earl.common.validate.annotation.ListValue.message}";Class<?>[] groups() default {};Class<? extends Payload>[] payload() default {};int[] vals() default {};//java8新特性,定义可重复注解,一个注解可能对多种情况进行分组标注,可能使用多个相同注解,这是校验注解的重复注解定义({ElementType.METHOD, ElementType.FIELD, ElementType.ANNOTATION_TYPE, ElementType.CONSTRUCTOR, ElementType.PARAMETER, ElementType.TYPE_USE})(RetentionPolicy.RUNTIME)public @interface List {ListValue[] value();}}创建

ValidationMessages.properties同名文件并配置默认消息提示properties文件读取中文乱码的问题件附录30,这个地方需要修改IDEA的File--Setting--Editor--File Encodings--将Properties Files中的Transparent native-to-ascii conversion勾选上并重新创建文件【最好将File Encodings中的所有编码格式都改成UTF-8】

xxxxxxxxxxcom.earl.common.validate.annotation.ListValue.message=必须提交指定的值自定义校验器

xxxxxxxxxx/*** @author Earl* @version 1.0.0* @描述* 自定义注解需要实现ConstraintValidator接口* ConstraintValidator<A extends Annotation, T>有两个泛型,第一个泛型是关联的注解@ListValue,第二个* 泛型是@ListValue注解能标注的地方,该接口中有两个抽象方法* @创建日期 2024/02/28* @since 1.0.0*/public class ListValueConstraintValidator implements ConstraintValidator<ListValue,Integer> {private Set<Integer> set=new HashSet<>();/*** @param constraintAnnotation* @描述 该方法能获取到ListValue注解中的属性值,该属性值能在isValid中对数据进行校验,遍历vals中的值封装到set集合中供* initialize方法对实际传参进行判断* @author Earl* @version 1.0.0* @创建日期 2024/02/28* @since 1.0.0*/public void initialize(ListValue constraintAnnotation) {int[] vals = constraintAnnotation.vals();for (int val:vals) {set.add(val);}}/*** @param value 要检验的实际入参* @param context* @return boolean* @描述 判断是否校验成功* @author Earl* @version 1.0.0* @创建日期 2024/02/28* @since 1.0.0*/public boolean isValid(Integer value, ConstraintValidatorContext context) {return set.contains(value);}}

SPU和SKU

SPU【Standard Product Unit】标准化产品单元,是一组可复用、易检索的标准化信息集合,是描述一个产品信息聚合的最小单位

通过SPU能知道商品的特性,比如手机的像素、分辨率、尺寸等

SKU【Stock Keeping Unit】库存量单位,库存进出计量的基本单元,以件、盒、托盘为单位

通过SKU能知道一个商品下面分哪些版本,比如同一种型号iphone有对应好几种颜色的不同版本,不同颜色又对应不同大小的内存,对应不同的版本有不同的售价,不同版本对应的库存量也不同

SPU更像java中的一个类,SKU像Java中的一个对象,同一款SKU除了版本不同和特定参数不同其他的特性都可以共享SPU中的特性信息【XS Max256G和64G的商品特性是相同的,比如大小、像素、芯片等】,商品的SPU信息称为基本属性【也叫规格与包装】,能完全决定库存和售价的属性称为销售属性

SPU包含一个商品分类的所有相同的基本属性、SKU包含了决定商品售价和库存量的差异化销售属性,一种商品分类的基本属性的属性名是一致的,属性值各有不同

SPU总结

即一个商品的SPU信息被设计为商品大类-属性分组-属性列表-属性值,同一类商品的大类-属性分组-属性列表是相同的,属性值有商品决定,属性值可以作为商品检索信息

基本属性是三级分类的【商品大类--属性分组--属性和属性值,如手机--基本信息--机身颜色 深空灰色】,每个商品分类有特性的属性分组,每个商品分组都有固定的规格参数列表,规格参数的值是不同商品决定的

属性信息可以供手机分类页面根据属性值【也叫规格参数】进行检索,

SKU总结

SKU信息决定一个商品的售价和库存量

每个SKU有一个唯一的编号,可以在商品界面的url看到

商品数据表设计

商品三级分类表--属性分组表从属三级分类,属性分组表和属性表通过属性关联表中的双方id关联起来

pms_attr:属性表

字段包含属性名【规格参数的属性名】、检索标志【1表示可检索属性,0表示不可检索】、属性类型、属性所属商品分类id

pms_attr_group:属性分组表

字段包含属性分组id、属性分组名、关联的商品分类id

pms_attr_attrgroup_relation:属性和属性分组关联表

字段包含关联分组id、属性id、属性分组id

pms_product_attr_value:商品属性值表

属性值是根据商品不同而不同的,所以设计一个商品属性值表,字段包含商品id、spu的id、属性id、属性名、属性对应的值;每个属性和属性值都是一条记录,一个商品的完整基本属性有很多条记录

商品属性表通过商品id或者spu的id统一查出来,

pms_spu_info:spu信息表

字段包含商品SPU的id、商品名字、商品描述、商品所属三级分类id,品牌id、商品所属状态,记录创建时间、更新时间

pms_sku_info:sku信息表

字段包含所属spu的id、sku标题、sku描述、sku名称、

pms_sku_images:sku图片

每个SKU的图片都存储在该表中,字段包含sku_id,图片url、每个图片都有一个记录

pms_sku_sale_attr_value:sku属性值表

字段包含sku的id、属性id、属性名、属性值、sku的每个属性都有一条记录

表逻辑

商品分类表、属性分组表、属性表、属性和属性分组关联表的关系

属性分组表和属性表通过

catelogId表明从属商品分类id,属性分组表和属性表通过属性和属性分组表关联商品属性值表通过属性

attrId和SPU属性表关联,通过SPU属性表的catelogId和商品分类信息关联,销售属性表通过skuid和sku信息表进行关联,通过spuid和spu信息进行关联,销售属性的属性名和属性值也在属性表中,和商品属性值表一样通过属性值id和属性值相关联说白了就是属性表定义属性名,属性名表有id和分类id;商品属性值表有主键、通过spuid绑定spu分类、通过属性值id绑定属性表中的属性名,通过attrVal指定属性值;销售属性值表有主见,通过skuId指定所属的sku,通过spuId指定所属的spu,通过attrId指定属性名,通过attrVal指定销售属性值

品牌关联分类

完善品牌列表的带条件分页模糊查询功能

一个可能关联多个商品分类,一个商品分类下也会有很多个品牌,多对多一般在数据库中就会有一张多对多的中间表pms_category_brand_relation,保存了商品id,分类id;为了避免做多表连接或者多表查询【这样很影响数据库性能】,在商品和分类关系表中添加了冗余字段商品名称和商品分类名称【这叫冗余存储,数据库数据单是分类就很多,为了保证效率只能这样。不出意外只是物品都有上万的数据。多表只能一个一个改。不然效率影响太大了。链表最多最多只能是两张】,这种冗余存储也会增加业务复杂度,当商品分类名称发生修改时,对应涉及到冗余存储的地方需要同时进行修改,当品牌名称改了,对应冗余存储的地方也同样需要同时进行修改,比较麻烦;当记录新增的时候需要单独查询出对应的冗余字段信息并对相应字段进行赋值

安装了mybatisX插件可以在对应的Dao中通过

ALT+Enter快捷键选择generate statement在对应的xml文件中创建出对应的SQL语句,xml文件中使用#{},如果dao方法中有两个以上的参数,一定要在参数列表中使用@Param注解为每个参数起对应的名字方便在xml文件中进行引用,否则很麻烦,需要使用${}和p0、p1之类的方式

SPU和SKU

属性分组

renren-fast-vue后台前端的分类菜单通过在表

sys_menu中使用sql脚本创建菜单,对应的所有前端菜单sql在,以后的项目前端页面直接拷贝,不再自己编写,前端接口文档地址公共维护到地址https://easydoc.net/s/78237135/ZUqEdvA4/HqQGp9TI【注意这个地址可能失效,要注意总结成文】,这里面有很多其他接口功能,课堂只讲一些主要功能

属性分组前端

需求:页面展示一个三级分类列表、点击列表展示该商品分类下的所有分组属性;包括后续的规格参数、销售属性都需要一个三级分类列表,因此将该三级列表单独抽取成一个组件放在

src/vues/modules/common下在

src/vues/modules/common下创建一个三级分类属性组件category.vue根据路由规则在

src/vue/modules/product目录下创建属性分组页面attrgroup.vue使用element-ui的Layout布局组件规划页面

gutter属性是每列中间的间距是20px,这是栅格系统的风格

el-row中每一行可以有24列,通过span属性告知一个el-col占用多少列

实现三级列表占用6列,表格数据占用18列

xxxxxxxxxx<el-row :gutter="20"><el-col :span="6"><div class="grid-content bg-purple"></div></el-col><el-col :span="6"><div class="grid-content bg-purple"></div></el-col><el-col :span="6"><div class="grid-content bg-purple"></div></el-col><el-col :span="6"><div class="grid-content bg-purple"></div></el-col></el-row>在第一列中使用树形组件的数据展示商品分类数据

拖拽、复选框、节点自动展开功能都不要,只展示数据、用catId来作为节点主键,组件名字叫menuTree

参数值为菜单数据,props属性

方法包括页面初始化时请求后端获取商品分类数据展示在属性菜单列表中

xxxxxxxxxx<template><el-tree :data="menu" :props="defaultProps" node-key="catId" ref="menuTree"></el-tree></template><script>export default {//import 引入的组件需要注入到对象中才能使用components: {},props: {},data() {//这里存放数据return {menu: [],expandeKey: [],defaultProps: {children: "children",label: "name"}};},}</script>在第二列中使用renren-fast逆向生成的属性分组列表来填充第二列数据,将相应的变量和方法都拷贝到attrgroup.vue中

父子组件传递数据

父子组件是vue中一个高级功能,在父组件attrgroup.vue中引用了子组件Category,我们希望实现子组件元素被点击后能通知父组件哪些元素被点击了,父组件知道子组件被点击的数据通知另一个子组件显示被点击数据关联的内容

子组件给父组件通过事件机制传递数据

子组件被点击时给父组件发送一个事件,携带上数据

给el-tree组件绑定单机事件node-click,回调自动传参节点原始数据,组件节点Node的数据,以及节点组件本身,这个单机事件写在子组件中,在子组件的回调函数中使用代码

this.$emit("tree-node-click",data,node,component)表示向父组件发送事件,事件名tree-node-click随意写,推荐按一般标准用短横线连接单词,后面接的是该事件传递的参数,这个事件名会在父组件中使用xxxxxxxxxxnodeClick(data,node,component){console.log("子组件被点击了:",data,node,component)this.$emit("tree-node-click",data,node,component)}在父组件对子组件引用的标签中添加上该事件,在父组件中定义对应的回调方法并接收子组件传递过来的参数

xxxxxxxxxx<template><el-row :gutter="20"><el-col :span="6"><category @tree-node-click="treeNodeClick"></category></el-col><el-col :span="18">...</el-col></el-row></template><script>import Category from "../common/category";export default {components: { Category},props: {},data() {return {};},methods: {treeNodeClick(data,node,component){console.log("父组件接收到子组件发送的事件:",data,node,component)},}</script>

分页查询

带条件分页查询属性分组

后端

根据商品分类id和搜索框关键字查询属性分组数据

编写后端根据商品分类id查询出对应的attrgroup表中的属性分组

使用

Map<String,Object>类型的参数和@RequestParam注解封装查询条件,请求路径中的Long类型参数catelogId的获取使用注解@PathVariable进行标注,使用分页查询方法queryPage进行分页查询【这里的QueryPage方法是renren-fast提供的,里面的很多API是使用common模块中utils下的renrenfast的Page工具类的方法】,返回PageUtils对象;传递特定的值在该方法的基础上扩展额外带特定参数的方法业务需求:分页查询属性分组数据,如果没有选择三级商品分类就查询所有属性分组,catelogId参数设置为0;如果有指定的三级商品分类就查询对应分类下的所有属性分组,catelogId设置为对应的商品分类的catId

后端分页查询实现方法

这个带条件分页查询实现很贴近企业的实现,这里的内容对应谷粒商城72P,以后好好总结一下这里,用MP和工具类做带条件分页查询

xxxxxxxxxx("attrGroupService")public class AttrGroupServiceImpl extends ServiceImpl<AttrGroupDao, AttrGroupEntity> implements AttrGroupService {/*** @param params* @return {@link PageUtils }* @描述 这个queryPage方法是renren-generator自动生成的** this.page(new Query<AttrGroupEntity>().getPage(params),new QueryWrapper<AttrGroupEntity>())* IPage中封装的分页信息,QueryWrapper是查询条件,* page方法是MyBatisPlus提供的一个方法传参IPage和一个查询条件* IPage的获取是通过renren-generator提供的工具类Query提供的,通过getPage方法可以将前端传入的查询条件中获取到分页信息* 比如PAGE是当前页码,LIMIT是每页显示记录数,ORDER_FIELD是排序字段,ORDER是排序方式、ASC是升序,实际上这些* 是常量,常量值是分页数据的key,该工具类通过从Map中获取数据封装到IPage对象中然后返回* new QueryWrapper<AttrGroupEntity>()是创建一个QueryWrapper对象,没有任何查询条件的时候就是查询所有* 公司里这些东西也是直接封装好的,** IPage<T> page(IPage<T> page, Wrapper<T> queryWrapper);是mybatisPlus扩展包下的方法,不需要引入分页插件就能直接使用** @author Earl* @version 1.0.0* @创建日期 2024/02/29* @since 1.0.0*/public PageUtils queryPage(Map<String, Object> params) {//这一步就已经把数据查出来了,封装在page对象中,PageUtils对page进行处理将数据读取出来统一封装到PageUtils中IPage<AttrGroupEntity> page = this.page(new Query<AttrGroupEntity>().getPage(params),new QueryWrapper<AttrGroupEntity>());//PageUtils是另一个工具类,将page对象传入其中,会自动将page中的分页参数传给PageUtils的属性值,这个PageUtils//也是renren-generator生成的,PageUtils对象的数据结构为/*** "page": {* "totalCount": 0,* "pageSize": 10,* "totalPage": 0,* "currPage": 1,* "list": [{* "attrGroupId": 0, //分组id* "attrGroupName": "string", //分组名* "catelogId": 0, //所属分类* "descript": "string", //描述* "icon": "string", //图标* "sort": 0 //排序* "catelogPath": [2,45,225] //分类完整路径* }]* }* */return new PageUtils(page);}/*** @param params* @param catelogId* @return {@link PageUtils }* @描述 分页查询请求的参数中有一个key字段,key字段就是检索关键字,分页查询参数和key都是连接在请求url后的,* 这个key是renren-generator封装在自动生成的前端列表组件中的搜索框的,因为这个搜索框只有一个,想要尽可能多的展示* 数据,需要对该key进行模糊匹配* 带搜索框的查询条件为select * from pms_attr_group where catelog_id=? and (attr_group_id=key or* attr_group_name like %key%* 即查询属性分组表中商品分类id为指定值且属性分组id为搜索框内容或者属性分组的名字模糊匹配搜素内容的属性分组* Spring中有一个工具类StringUtils.isEmpty(str)方法能判断str是否空字符串,自5.3版本起,isEmpty(Object)已建议弃用,* 使用hasLength(String)或hasText(String)替代。* QueryWrapper的and方法可以接受函数式接口Consumer,自动传参QueryWrapper,可以在函数式接口中连续添加查询条件* @author Earl* @version 1.0.0* @创建日期 2024/02/29* @since 1.0.0*/public PageUtils queryPage(Map<String, Object> params, String catelogId) {if(catelogId=="0"){//查询所有属性分组IPage<AttrGroupEntity> page = this.page(new Query<AttrGroupEntity>().getPage(params),new QueryWrapper<>());return new PageUtils(page);}else{String key = (String) params.get("key");QueryWrapper<AttrGroupEntity> wrapper = new QueryWrapper<AttrGroupEntity>().eq("catelog_id", catelogId);if (StringUtils.hasLength(key)) {wrapper.and(obj->{obj.eq("attr_group_id",key).or().like("attr_group_name",key);});}IPage<AttrGroupEntity> page = this.page(new Query<AttrGroupEntity>().getPage(params),wrapper);return new PageUtils(page);}}}

前端

前端逻辑

点击三级商品分类,在触发子组件向父组件发起事件时判断点击节点是否三级商品节点【node.level】,一级和二级商品节点不查询对应的属性分组;

如果点击节点的catId发生变化就向服务器带条件分页查询发起请求并获取响应结果;

页面初始化时查询catId为0的数据

新增属性分组

新增属性分组包括组名、排序、描述、组图标、所属分类ID

要点:

需求详解

点击新增弹出对话框,分别填入属性分组名、排序、属性分组描述、分组图标和所属分类信息

所属分类信息使用级联列表来选择,

所属商品分类应该做成下拉框【级联选择器】来供后台选择,使用el-cascader组件

options属性是指定级联列表的数据对象categories;

props属性是指定级联列表的value、label和children,其中value属性是当列表被选中封装进v-model绑定变量dataForm.catelogIds中的值,注意value是指定options绑定变量中的属性,但是封装到catelogIds中的数据包含多级列表中父列表和子列表对应value的数组,同时这个dataForm.catelogIds中要有完整的多级列表数组才能对分类属性进行回显,label是列表展示的内容,比如商品分类名字,children是一个列表的子节点对应的categories中的子节点数据集合【注意如果最后一级列表的原始数据还含有children属性,即使该children属性为空数组,最后也会展示为一个多余的空列表】

对于解决封装的实体类对象第三级分类数据没有children属性值但仍然带有children属性的处理办法:在category实体类上的children属性上使用jackson包下的@JsonInclude注解,其中的value类型是一个枚举类型,可以设置的枚举值包含

ALWAYS、NON_NULL【字段不为NULL才响应包含该字段】、NON_EMPTY【字段不为空的时候才返回该字段】,这样就能自动实现在封装数据对象为json时某个属性的值为空数组或者空内容的情况下自动不封装该数据,这个应该是转换成json数据的时候才自动判断的添加数据以后的数据回显是通过子组件发送请求以后,通过this.$emit给父组件发送一个名为refreshDataList的事件,父组件监听到该事件后,调用获取属性分组列表数据的接口重新获取属性列表数据

该级联选择器可以绑定了一个change事件

el-cascader组件添加一个filterable组件就能添加级联列表的快速搜索功能

placeholder属性可以设置搜索框的默认值,可以告知用户可以进行搜索

this.$nextTick(()=>{})方法是组件渲染完成以后再回调该方法中参数定义的方法

xxxxxxxxxx<div class="block"><el-form-item label="所属分类" prop="catelogId"><!--options是绑定商品数据,props属性是指定级联列表的属性值,光有options是不行的,还需要用props属性指定级联列表中的具体值props中有很多值可以填,详情看官方文档,这里介绍部分,value是指定哪个选项值作为标签对象的值[即需要响应给后端的catId],label是指定哪个值作为标签的属性值来展示,children是设置一个标签的子集合,对应返回对象的children注意这个组件有多少层是根据一个标签下是否还含有children属性名来确定的,封装的时候由于最后一级分类没有子节点了,但是还有children属性,此时会显示有四级选框,且最后一级选框什么内容都没有,此时需要设置后端让后端没有子节点的情况下不要封装children属性,可以在category实体类上的children属性上使用jackson包下的@JsonInclude注解,其中的value类型是一个枚举类型,可以设置的枚举值包含ALWAYS、NON_NULL【字段不为NULL才响应包含该字段】、NON_EMPTY[字段不为空的时候才返回该字段]注意:级联列表中的props属性中的v-model值会自动封装成一个数组,该数组的元素就是三级列表对应的props属性中的catId,但是提交分类id的时候只需呀提交最后一个id,提交数据的时候注意处理一下子组件点击提交以后除了发送请求给后端新增属性分组记录以外,还会使用this.$emit给父组件发送一个名为refreshDataList的事件,父组件中监听了该事件,调用getDataList自动更新属性分组列表修改的时候发现商品分类数据不能回显,这是因为后端发过来的数据,dataForm.catelogId只是其中一个数据,并不是一个包含完整三级分类的ID的数组,所以无法进行回显--><el-cascaderv-model="dataForm.catelogIds":options="categories":props="props"></el-cascader></el-form-item></div><div class="block"><span class="demonstration">hover 触发子菜单</span><el-cascaderv-model="value":options="options":props="{ expandTrigger: 'hover' }"@change="handleChange"></el-cascader></div>存在问题:点击修改的时候由于所属分组的

dataForm.catelogIds没有获取到完整一级到三级商品分类的catId数组,级联列表无法回显商品分类数据后端给属性分组实体类添加一个数据库没有相应字段的商品三级分类catId的List数组【会自动被处理成数组】,在根据属性分组id查询分组信息的同时,获取到商品分类ID并递归查询出该商品分类的所有一二级实体类的catId并封装成List集合存入返回的属性分组对象的对应属性中一并返回

前端对话框关闭时会触发closed事件,在触发对话框关闭的同时将三级商品分类的catId数组初始化,避免打开对话框时商品分类信息没有变化

mp没有分页插件,原生的page方法能返回分页数据,但是无法显示当前页码和总记录条数等信息

配置分页插件

属性分组关联属性

需求

在属性分组页面点击关联能弹框显示当前属性分组下的所有属性,展示属性的id、属性名、可选值、并可以对属性进行操作,但是获取的还是完整的属性所有字段

点击操作中的移除按钮能批量移除掉属性和属性分组的关联记录

业务实现

前端发送请求